Zarządzanie i monitorowanie infrastruktury centrum danych

Trend zdalnej kontroli nad centrami danych rozwijał się w najlepsze od dłuższego czasu, a pandemia tylko go przyśpieszyła. Ci, którzy nie mają dziś odpowiednich narzędzi, ryzykują spadkiem wydajności, a nawet brakiem dostępu do usług data center.

Dzięki właściwej strategii, opartej na wdrażaniu specjalnych narzędzi albo korzystaniu z zewnętrznej usługi zdalnego zarządzania centrum danych, firmy i instytucje mogą mieć pod kontrolą wszystkie kluczowe procesy. Dotyczą one rutynowych prac w ramach utrzymania data center, ale także skalowania jego pojemności, zarządzania infrastrukturą i rozwiązywania problemów. Nie wymaga to, w wielu przypadkach, fizycznej obecności administratora w centrum danych, ponieważ może on korzystać z nowoczesnego rozwiązania do zarządzania przy użyciu wybranego przez niego urządzenia końcowego – laptopa z przeglądarką internetową, smartfona albo tabletu z zainstalowaną aplikacją. W ten sposób jest w stanie wykonywać swoje zadania bez względu na to, jak funkcjonuje w danym momencie centrum danych, rozwiązując bieżące problemy nawet w okresach jego nieplanowanych przestojów.

Tę ostatnią możliwość daje wdrożenie koncepcji zwanej zarządzaniem „out of band” management (OOB), czyli pozapas-mowym. W przypadku zarządzania „in-band” wykorzystuje się te same sieci, na których opiera się działanie centrum danych – okablowanie Ethernet i światłowody łączące serwery, pamięci masowe i pozostałą infrastrukturę. Z kolei OOB wymaga stworzenia komunikacji z centrum danych przy użyciu innych sieci, w tym komórkowych.

Infrastrukturą centrum danych można zdalnie zarządzać zarówno przy użyciu narzędzi programowych, jak i sprzętowych. W obu przypadkach istnieje możliwość takiej konfiguracji rozwiązania, aby pracujący zdalnie administrator, czy też użytkownik o odpowiednich uprawnieniach, mógł wykonywać wszelkie operacje w systemach operacyjnych urządzeń tak, jakby odbywało się to lokalnie. Zdaniem części specjalistów rozwiązania sprzętowe mają tę przewagę nad programowymi, że pozwalają na dostęp do urządzeń z tzw. niskiego poziomu. Tym samym użytkownik zdalny może dostać się do systemu BIOS, dokonać jego sprzętowego restartu, a w połączeniu z zarządzaną listwą zasilającą – monitorować czy restartować zasilanie.

Urządzenia do zdalnego zarządzania infrastrukturą data center posiadają zaawansowane funkcjonalności, przykładowo pozwalają na zdalne, niskopoziomowe zamontowanie nośnika danych do serwera i w rezultacie instalację czy reinstalację systemu operacyjnego z odległej lokalizacji. Rozwiązania sprzętowe mają być także bezpieczniejsze.

– W tym przypadku poprzez bezpieczeństwo rozumiem możliwość zastosowania specjalnych algorytmów szyfrowania danych, które przeliczane są poprzez urządzenia zewnętrzne. Zatem nie ma możliwości ingerencji w nie z poziomu programowego. Wysokiej klasy zewnętrzna infrastruktura zarządzająca to również niezależne łącza, redundancja połączeń i zasilania – podkreśla Tomasz Kruszyński, Country Manager Aten.

„Zdrowie” centrum danych musi być monitorowane

Dla niezawodności infrastruktury data center kluczowy jest monitoring parametrów pracy i alarmów aparatury obiektowej, zwłaszcza elementów składowych systemów dystrybucji energii i chłodu. Duży nacisk kładzie się też na kontrolowanie warunków środowiskowych, zwłaszcza temperatury i wilgotności. Niekorzystne zmiany tych parametrów mogą być pierwszym sygnałem, że w centrum danych narasta problem z jego wydajnością, a w konsekwencji – niezawodnością.

– Także monitoring efektywności data center w dużej mierze polega na analizie realnych odczytów temperatury. Zakładany na etapie budowy obiektu współczynnik PUE, czyli Power Usage Efectiveness, jest realnie osiągany dopiero po spełnieniu szeregu założeń projektowych. Weryfikując różnice między projektem a odczytywanymi danymi, możemy znaleźć źródło niższej niż projektowana efektywności centrum danych – mówi Sebastian Zasina, Data Center Solution Architect w APC by Schneider Electric.

To rozwiązania DCIM (Data Center Infrastructure Management) monitorują i zarządzają wykorzystaniem zasobów centrum danych, w tym zużyciem energii przez cały sprzęt IT (serwery, pamięci masowe, przełączniki sieciowe). Kontrolują komponenty fizycznej infrastruktury data center, takie jak zasilacze awaryjne (UPS), jednostki dystrybucji zasilania (PDU) i klimatyzatory precyzyjne dla serwerowni (CRAC). Narzędzia DCIM mają pomóc administratorom osiągnąć maksymalną efektywność energetyczną i zapobiec problemom ze sprzętem, które mogą prowadzić do przestojów.

– Wybrane narzędzie musi mieć intuicyjny interfejs, proste mechanizmy dodawania nowych urządzeń i ustawiania ich monitorowania. Z jednej strony ważna jest bieżąca sytuacja, ale z drugiej również pewne trendy, które powinno się obrazować w raportach, najlepiej tworzonych samodzielnie – tłumaczy Krzysztof Krawczyk, IT Solutions Sales Manager w Vertivie.

Bardzo ważne jest monitorowanie kluczowych punktów pomiarowych, które odzwierciedlają stan urządzenia. Przykładowo dla zasilacza UPS będzie to praca z sieci lub z baterii, stan naładowania baterii czy obecne obciążenie. Jeśli status zostanie zmieniony albo osiągnięty zostanie próg krytyczny, musi być o tym poinformowana osoba odpowiedzialna za ten element infrastruktury.

Nowym trendem staje się platforma DCIM hostowana nie lokalnie, ale w chmurze. Dzięki temu ma ona oferować nowe funkcjonalności i eliminować takie problemy z tradycyjnymi narzędziami, jak długi czas wdrażania i złożoność rozwiązania. Dostarczany w modelu SaaS chmurowy DCIM zapewnia prostsze wdrażanie, natomiast aktualizacje oprogramowania, nowy firmware czy poprawki bezpieczeństwa są dostarczane automatycznie. Dodatkowo dużo łatwiejsze staje się odzyskiwanie danych po awarii – dzięki przechowywanej stale w chmurze kopii zapasowej systemu.

Nowa generacja rozwiązań DCIM oferuje, w porównaniu z tradycyjnymi narzędziami, bardziej zaawansowane funkcje, wykorzystując pewne mechanizmy sztucznej inteligencji, uczenia maszynowego (ML) oraz przeprowadzanej w czasie rzeczywistym analityki gromadzonych danych. Przykładowo platforma Schneider Electric gromadzi anonimowe dane od wielu klientów na potrzeby analityki predykcyjnej. Producent twierdzi, że poprzez porównanie w czasie rzeczywistym wydajności infrastruktury konkretnego klienta z wzorcem uzyskanym z analizy wielu podobnych środowisk, można stwierdzić, kiedy kondycja jakiegoś komponentu data center odbiega od stanu prawidłowego, co wymaga działań zapobiegających awarii.

Zdalne zarządzanie i monitorowanie wymaga odpowiednich narzędzi

Serwery konsoli szeregowych to urządzenia z dużą liczbą portów szeregowych, co umożliwia podłączenie wielu elementów infrastruktury data center – serwerów, routerów czy przełączników sieciowych. Jak sugeruje nazwa rozwiązania, daje ono dostęp do tych urządzeń za pośrednictwem ich konsol zarządzania. Administratorzy mogą zdalnie logować się do podłączonego sprzętu IT, korzystając z niezależnej od działania centrum danych łączności – modemów komórkowych, komercyjnego internetu oraz takich protokołów komunikacji, jak telnet czy SSH.

Przełączniki KVM (Keyboard, Video and Mouse) zaprojektowano tak, by zapewniały administratorowi centrum danych zdalny dostęp do serwerów i komputerów, z wykorzystaniem ekranu, myszy i klawiatury. Idea jest prosta: jeśli korzystaliśmy kiedyś z jednego komputera z wieloma monitorami, to KVM działa dokładnie odwrotnie, umożliwiając administratorom sterowanie wieloma komputerami przy użyciu jednego zestawu klawiatury, myszy i monitora.

DCIM (Data Center Infrastructure Management) dostarcza wielu informacji uzupełniających dane uzyskiwane z serwerów konsoli. Podczas, gdy te ostatnie pozwalają dotrzeć np. do serwerów i diagnozować występujące w nich problemy, narzędzia DCIM pomogą ujawnić problemy zarówno ze sprzętem IT, jak i infrastrukturą pomocniczą. Wykraczają przy tym poza podstawowe funkcje monitorowania urządzeń, umożliwiając operatorom centrów danych zrozumienie, co dzieje się w ich środowisku, w tym poprzez informowanie o stanie rozwiązań zasilających i chłodzących. Są w stanie zapobiegać ewentualnym problemom w data center oraz ułatwiać planowanie optymalnego rozmieszczenia sprzętu i przyszłego rozwoju środowiska IT.

Edge wymusza zdalne zarządzanie

Znaczenie zdalnego zarządzania i monitoringu centrum danych będzie rosło także z tego powodu, że coraz powszechniejsze stają się wdrożenia infrastruktury brzegowej. Edge computing eliminuje konieczność przekazywania informacji do odległej chmury lub innych scentralizowanych systemów, umieszczając wydajne zasoby obliczeniowe, pamięci masowe i sieciowe jak najbliżej użytkowników i urządzeń końcowych. Zastosowań, w których nie będzie można pozwolić sobie na większe opóźnienia w przesyłaniu i przetwarzaniu danych, będzie przybywać, zwłaszcza wraz z upowszechnieniem się technologii 5G.

– W związku z rozwojem technologii edge należy przyjąć, że w najbliższych latach, poza centralnym data center, trzeba będzie monitorować małe, rozproszone geograficznie serwerownie, ograniczone rozmiarem nawet do jednej szafy rackowej. Rozwiązanie monitoringu powinno umożliwiać włączenie nowych lokalizacji do jednego, spójnego systemu – mówi Sebastian Zasina.

Zapotrzebowanie na wdrożenia infrastruktury edge będzie rosło w wielu branżach, w tym ochronie zdrowia, handlu detalicznym czy przemyśle. Ponieważ będzie ona miała krytyczne znaczenie dla funkcjonowania aplikacji, to wymagane będzie takie samo wsparcie, jak w przypadku tradycyjnych centrów danych.

Pandemia przynosi trwałe zmiany

Zmuszając do zachowania dystansu społecznego i pracy na odległość, pandemia COVID-19 przeniosła życie zawodowe i osobiste do przestrzeni cyfrowej. Doszło do ogromnego wzrostu ruchu sieciowego, generowanego z jednej strony przez połączenia wideokonferencyjne, aplikacje chmurowe, szyfrowaną komunikację VPN i zdalną edukację, z drugiej – przez rozrywkę i gry online. W rezultacie chyba jeszcze nigdy nie było tak ważne nieprzerwane i bezproblemowe działanie centrów danych, obsługujących użytkowników zdalnych komputerów, narzędzi i platform.

Dlatego zarówno działy IT w organizacjach posiadających niewielkie serwerownie, jak i zespoły operacyjne dostawców chmury publicznej muszą zapewnić rutynowe i prewencyjne utrzymanie posiadanej infrastruktury, zwiększać jej wydajność i rozwiązywać problemy techniczne, jeśli się pojawią.

– W okresie pandemii wiele organizacji dopuściło pracę zdalną, ale posiadane przez nich narzędzia często nie są do niej dostosowane. Tradycyjne systemy monitoringu serwerowni to najczęściej lokalna stacja robocza z zainstalowanym dedykowanym oprogramowaniem dla obsługi serwerowni. Wystawienie tak zbudowanego systemu „na zewnątrz” odbywa się często kosztem wydajności, wygody użytkowania czy bezpieczeństwa danych – ostrzega Sebastian Zasina.

Klienci muszą sięgnąć po takie rozwiązania, które na stałe zmienią ich sposób zarządzania centrum danych. I nie ma znaczenia to, ile pandemia jeszcze potrwa, albo czy nadejdzie druga fala koronawirusa. W okresie tzw. nowej normalności cofnięcie się do dawnego, wyłącznie lokalnego modelu kontroli infrastruktury będzie krokiem w tył.

Zdaniem specjalisty

Krzysztof Krawczyk, IT Solutions Sales Manager, Vertiv

Krzysztof Krawczyk, IT Solutions Sales Manager, Vertiv Coraz rzadziej dokonujemy obserwacji polegających na regularnych wizytach w miejscu, gdzie pracują urządzenia wymagające kontroli. W większości polegamy na alarmach, które są wysyłane do centralnych systemów monitorujących. Coraz bardziej staramy się działać predykcyjnie, czyli przewidywać potencjalne usterki na podstawie wcześniejszego doświadczenia i coraz częściej wyręczają nas w tym systemy sztucznej inteligencji. Pandemia COVID-19, podczas której unikamy niepotrzebnego przemieszczania się, tylko wzmacnia ten kierunek.

Sebastian Zasina, Data Center Solution Architect, APC by Schneider Electric

Sebastian Zasina, Data Center Solution Architect, APC by Schneider Electric Na pewno infrastrukturę data center monitoruje się dzisiaj w sposób bardziej inteligentny, niż jeszcze kilka lat temu. Duża ilość czujników i danych spływających z różnych urządzeń powoduje, że manualny monitoring, zwłaszcza dużych obiektów DC, stał się wyzwaniem. Rozwiązania DCIM wzbogaciły się o zaawansowaną analitykę i elementy sztucznej inteligencji. System monitoringu centrum danych nie odpowiada już tylko na pytanie „co się wydarzyło?”. Pomaga nam również wyciągać wnioski i odpowiedzieć na pytanie „co się może wydarzyć oraz jak temu zapobiec?”. To jest duża zmiana jakościowa.

Tomasz Kruszyński, Country Manager, Aten

Tomasz Kruszyński, Country Manager, Aten W zdalnym zarządzaniu centrami danych rozwiązania sprzętowe – przełączniki KVM w połączeniu z serwerami konsoli szeregowych i listwami PDU – pokazują swoją przewagę nad narzędziami programowymi. Przy ich zastosowaniu możliwe jest niskopoziomowe zarządzanie nie tylko serwerami, ale właściwie wszystkim, co może znaleźć się w data center, a więc przełącznikami sieciowymi, rejestratorami, czy systemami NAS. Naturalnie, dobry hardware musi być opatrzony odpowiednim oprogramowaniem spinającym, które pozwoli nie tylko na bieżący dostęp, ale i stałe monitorowanie działania infrastruktury oraz urządzeń.

Podobne artykuły

Schneider Electric: AI wyzwaniem i szansą dla centrów danych

W obliczu rozwoju sztucznej inteligencji i rosnącego zapotrzebowania na moc pilną potrzebą stała się poprawa efektywności centrów danych – podkreślano podczas Innovation Summit Paris 2024.

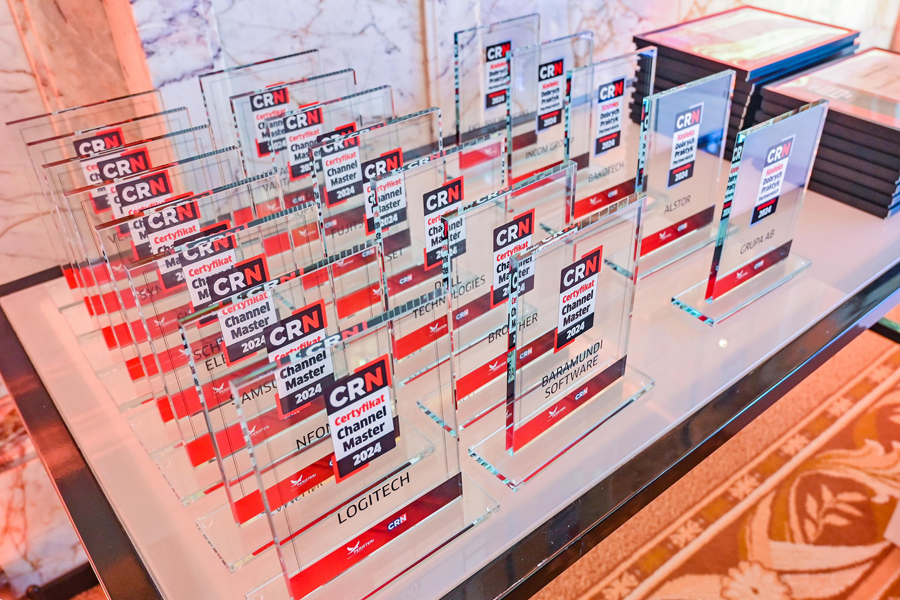

Channel Master 2024: zdobywcy certyfikatów!

Procedurę certyfikacji Channel Master, przeprowadzoną zgodnie z wytycznymi od integratorów IT, w tym roku pozytywnie przeszło piętnastu producentów. Certyfikat stanowi dowód najwyższej dbałości o wysokie standardy i jakość bieżącej obsługi oraz o rozwój ekosystemu partnerskiego.

Zdobywcy Certyfikatu Channel Master 2024

Jako dowód najwyższej dbałości o wysokie standardy i jakość bieżącej obsługi oraz rozwoju ekosystemu partnerskiego Certyfikat Channel Master 2024 został przyznany 15 producentom.