Koncerny chmurowe nakręcą popyt na serwery AI

Średni czas dostaw wynoszący 40 tygodni skróci się o połowę w II kw. 2024 r.

Trend w kierunku rozwoju własnych układów ASIC narasta wśród amerykańskich gigantów chmurowych.

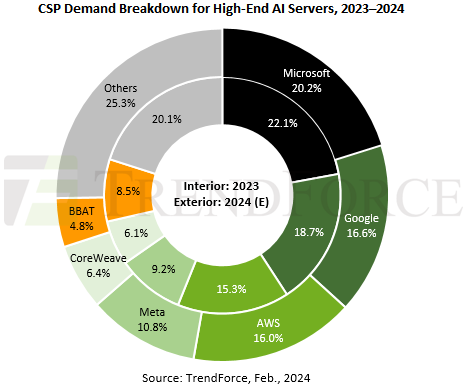

W tym roku chmurowi giganci nakręcą popyt na wysokiej klasy serwery AI — według prognozy TrendForce. Przewiduje się, że Microsoft (20,2 proc.), Google (16,6 proc.), AWS (16 proc.) i Meta (10,8 proc.) mają łącznie odpowiadać za ponad 60 proc. światowego popytu. Wiodącymi będą serwery oparte na procesorach graficznych Nvidii. Serwery AI według analizy to systemy z układami Nvidii, AMD lub innymi najwyższej klasy układami ASIC.

Sankcje USA na Chiny wyzwaniem dla Nvidii

Pomimo mocnej pozycji Nvidii w sektorze centrów danych — dzięki jej serwerowym GPU obejmującym do 70 proc. rynku sztucznej inteligencji — wyzwania nadal pojawiają się. Przyszły rozwój firmy ograniczają według TrendForce istotne wyzwania: po pierwsze amerykański zakaz eksportu technologii skłonił Chiny do usamodzielnienia się w zakresie czipów AI, a Huawei stał się godnym uwagi przeciwnikiem. Rozwiązania Nvidii przeznaczone dla Chin mogą nie dorównywać opłacalnością flagowym modelom, potencjalnie osłabiając jej dominację na rynku.

Po drugie, trend w kierunku własnego rozwoju układów ASIC wśród amerykańskich gigantów chmurowych, w tym Google, AWS, Microsoft i Meta, nasila się z roku na rok ze względu na skalę i koszty. Do tego AMD wywiera presję, oferując swoje produkty za 60–70 proc. ceny porównywalnych modeli Nvidii. Oczekuje się, że Microsoft będzie najbardziej entuzjastycznym odbiorcą wysokiej klasy rozwiązań AMD w 2024 roku.

Nvidia dąży natomiast do utrzymania pozycji lidera poprzez dywersyfikację swojego portfolio. Zamierza proponować agresywne ceny nowych rozwiązań, aby przyciągnąć CSP. Planuje poszerzyć swój zasięg na rynku, rozpoczynając negocjacje z głównymi graczami, takimi jak Meta, Google, AWS i OpenAI, wykorzystując model NRE, ukierunkowując ekspansję na branże telekomunikacyjną, motoryzacyjną i gier.

Oczekuje się, że obecny średni czas dostaw wynoszący 40 tygodni skróci się o połowę w II kw. 2024 r., w miarę jak zostaną uruchomione nowe moce produkcyjne. Ma to na celu złagodzenie wąskich gardeł w łańcuchu dostaw, które utrudniają dostępność serwerów AI z powodu niedoborów GPU.

Podobne aktualności

Pionier bezpieczeństwa AI – Darktrace sprzedany za 5,3 mld dol.

Dołączy do portfolio specjalistów od cyberbezpieczeństwa, należących do Thoma Bravo.

65 proc. polskich firm nie mierzy efektywności wdrożeń AI

Już ponad jedna czwarta firm w Polsce wdrożyła narzędzia AI, a kolejne 30 proc. zrobi to w tym roku. Jednak większość używających tej technologii nawet nie sprawdza, czy jest ona efektywna.

W Polsce powstała AI Chamber (Izba AI)

„Chcemy reprezentować interesy polskich firm” – zapowiada założyciel i prezes AI Chamber, Tomasz Snażyk. Organizacja wskazuje swoje główne cele.