7 trendów w obszarze AI w 2024 r.

Bernd Greifeneder, CTO i ekspert od AI firmy Dynatrace, opisuje 7 trendów w dziedzinie sztucznej inteligencji na rok 2024, skupiając się na takich zagadnieniach jak generatywna AI, cyfrowe systemy odpornościowe, zarządzanie danymi i bezpieczeństwo cyfrowe.

- Kompleksowe podejście do sztucznej inteligencji

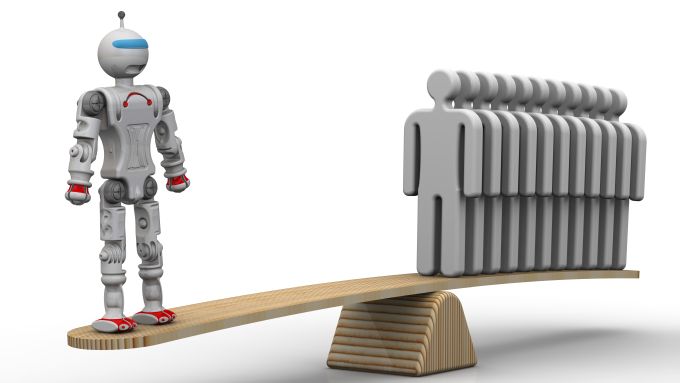

W 2024 r. na popularności zyska generatywna sztuczna inteligencja (GenAI), a organizacje przekonają się, że technologia ta, choć daje początek ogromnym zmianom, sama w sobie nie jest w stanie zapewnić znaczącej wartości.

W rezultacie firmy będą dążyć do podejścia opartego na złożonej AI, które łączy generatywną sztuczną inteligencję z jej innymi rodzajami i dodatkowymi źródłami danych. Takie podejście umożliwi bardziej zaawansowane przetwarzanie danych i sprawi, że wyniki dostarczane przez AI będą precyzyjne oraz osadzone w kontekście.

- Kod generowany przez sztuczną inteligencję potrzebuje cyfrowego układu odpornościowego

W przyszłym roku więcej organizacji doświadczy poważnych awarii usług cyfrowych z powodu niskiej jakości kodu oprogramowania.

Deweloperzy będą w coraz większym stopniu wykorzystywać autonomiczne agenty AI (Autonomous Agents to rodzaj sztucznej inteligencji AI, która może wykonywać zadania bez udziału człowieka) do pisania dla nich kodu, narażając swoje organizacje na zwiększone ryzyko nagłych problemów, które wpływają na doświadczenia klientów i użytkowników. Wynika to z faktu, że wyzwanie związane z utrzymaniem kodu wygenerowanego przez autonomicznego agenta jest podobne do zachowania kodu stworzonego przez programistów, którzy opuścili organizację. Żaden z pozostałych członków zespołu nie rozumie w pełni kodu. Z tego powodu nikt nie może szybko rozwiązać problemów, gdy się pojawią.

Wyzwania te skłonią organizacje do opracowania cyfrowych systemów odpornościowych w celu ochrony kodu od wewnątrz, poprzez zapewnienie jego domyślnej odporności. Aby to umożliwić, niezbędne będzie wykorzystanie możliwości predykcyjnej sztucznej inteligencji do automatycznego przewidywania problemów w kodzie lub aplikacjach i uruchamiania natychmiastowej, zautomatyzowanej reakcji w celu ochrony – w ostateczności – doświadczenia użytkownika.

- Nastał czas CAIO

Firmy będą coraz częściej tworzyć stanowiska dla menadżerów gotowych do zarządzania obszarem bezpieczeństwa i zgodności AI w organizacjach.

Coraz bardziej przyzwyczajeni do korzystania z narzędzi takich jak ChatGPT w życiu osobistym, pracownicy będą szukać w AI cennego systemu wsparcia zwiększającego ich produktywność w pracy. Organizacje już zdały sobie sprawę, że jeśli nie upoważnią swoich pracowników do oficjalnego korzystania z narzędzi AI, to będą oni to robić bez zgody pracodawców.

Z tego powodu przedsiębiorstwa zaczną tworzyć stanowisko dyrektora ds. sztucznej inteligencji (CAIO), który będzie nadzorował wykorzystanie tych technologii w sposób analogiczny do działalności menadżerów ds. bezpieczeństwa lub CISO.

CAIO będzie koncentrować się na opracowywaniu polityk oraz edukowaniu i wzmacnianiu kompetencji pracowników w zakresie właściwego korzystania ze sztucznej inteligencji w celu ochrony organizacji przed przypadkowym nieprzestrzeganiem przepisów, wyciekiem własności intelektualnej lub zagrożeniami bezpieczeństwa. Praktyki te utorują drogę do powszechnego przyjęcia sztucznej inteligencji w biznesie. W miarę rozwoju tego trendu AI stanie się dobrem powszechnym, podobnie jak telefon komórkowy.

- Obserwowalność danych stanie się obowiązkowa

Organizacje będą dążyć do bardziej inteligentnej automatyzacji i szybszego podejmowania decyzji.

Ilość danych podwaja się co dwa lata, a biznes stara się je pozyskiwać w celu szybszej analizy na większą skalę.

Jednak koszty i ryzyko związane z niską jakością danych są bardziej znaczące niż kiedykolwiek wcześniej. W niedawnym badaniu przeprowadzonych na praktykach DevOps, 57% z nich stwierdziło, że brak obserwowalności danych utrudnia automatyzację w sposób zgodny z przepisami. W rezultacie będziemy coraz częściej wymagać rozwiązań zapewniających szybką obserwowalność danych, umożliwiając ich pozyskiwanie przy zachowaniu kryteriów wysokiej jakości i wiarygodności.

Zwiększona obserwowalność danych umożliwi użytkownikom, takim jak zespoły ds. operacji IT i analityki biznesowej, zrozumienie dostępności danych oraz struktury, dystrybucji, relacji i ich pochodzenia we wszystkich źródłach, w tym na różnych platformach w rozproszonych środowiskach hybrydowych i wielochmurowych.

- AI przyczyni się do zmniejszenia śladu węglowego rozwiązań chmurowych

W 2024 r. połączona presja związana z przyjęciem bardziej zrównoważonych środowiskowo praktyk biznesowych i radzeniem sobie z rosnącymi kosztami utrzymania chmury spowoduje, że obserwowalność z priorytetu IT stanie się wymogiem biznesowym.

Zwiększone wykorzystanie sztucznej inteligencji przez organizacje będzie kluczowym czynnikiem napędzającym ten trend, ponieważ większe zużycie zasobów w chmurze skutkuje zwiększonym śladem węglowym.

Analityka danych oparta na sztucznej inteligencji może pomóc firmom w sprostaniu tym wyzwaniom i udoskonaleniu praktyk FinOps i sustainability. Będzie to możliwe poprzez dostarczanie przydatnych informacji i inteligentną automatyzację, która wyeliminuje nieefektywność w działaniu środowisk chmurowych.

Zwiększone wykorzystanie obserwowalności opartej na sztucznej inteligencji umożliwi ponadto automatyczną koordynację systemów w celu optymalnego wykorzystania zasobów, zmniejszenie emisji i kosztów eksploatacji chmury. W rezultacie będziemy obserwować rosnące zainteresowanie przypadkami użycia obserwowalności poza działem IT.

- Sprawna inżynieria platformowa to klucz

Niezawodny i bezpieczny proces ciągłego dostarczania oprogramowania będzie równie istoty dla utrzymania ciągłości działania w biznesie, co jakość i bezpieczeństwo usług cyfrowych, na których polegają dzisiaj klienci i użytkownicy końcowi.

Będziemy świadkami przesunięcia w kierunku produktyzacji narzędzi wykorzystywanych do napędzania najlepszych praktyk inżynierii DevOps, bezpieczeństwa i niezawodności witryn. Spowoduje to wysunięcie się na pierwszy plan inżynierii platform, ponieważ organizacje skodyfikują know-how i możliwości potrzebne do zautomatyzowania ciągłości dostarczania oprogramowania.

W miarę utrzymywania się tego trendu, procesy te będą uruchamiane za pośrednictwem interfejsów programowania aplikacji (API), które automatyzują zadania w oparciu o wgląd w dane obserwowane w czasie rzeczywistym.

- Zespoły ds. bezpieczeństwa będą dążyć do bardziej inteligentnej analizy zagrożeń

W 2024 r. rozwiązania analizy zagrożeń nowej generacji stopniowo zastąpią systemy zarządzania informacjami i zdarzeniami bezpieczeństwa (SIEM).

Zespoły ds. bezpieczeństwa będą mogły rozszerzyć swoje możliwości, wykraczając poza analizę dzienników, w celu uzyskania dostępu do kontekstu zapewnianego przez szerszy zakres modalności danych i różne rodzaje sztucznej inteligencji – od generatywnej, po przyczynową, kończąc na predykcyjnej.

W rezultacie firmy uzyskają dostęp do głębszej i dokładniejszej i zautomatyzowanej analizy zagrożeń, pomagając chronić swoje aplikacje i dane przed coraz bardziej wyrafinowanymi zagrożeniami.

Dynatrace działa w obszarze zunifikowanej obserwowalności i bezpieczeństwa. Główna siedziba firmy znajduje się w a Bostonie. Natomiast drugie co do wielkości centrum R&D firmy jest zlokalizowane w Gdańsku.

Podobne aktualności

Pionier bezpieczeństwa AI – Darktrace sprzedany za 5,3 mld dol.

Dołączy do portfolio specjalistów od cyberbezpieczeństwa, należących do Thoma Bravo.

65 proc. polskich firm nie mierzy efektywności wdrożeń AI

Już ponad jedna czwarta firm w Polsce wdrożyła narzędzia AI, a kolejne 30 proc. zrobi to w tym roku. Jednak większość używających tej technologii nawet nie sprawdza, czy jest ona efektywna.

W Polsce powstała AI Chamber (Izba AI)

„Chcemy reprezentować interesy polskich firm” – zapowiada założyciel i prezes AI Chamber, Tomasz Snażyk. Organizacja wskazuje swoje główne cele.