Wirtualne Środowiska pod ostrzałem

Cyberprzestępcy chętnie biorą na cel środowiska zwirtualizowane. I choć przedsiębiorstwa zazwyczaj dysponują narzędziami do ochrony wirtualnych maszyn, nie zawsze potrafią je odpowiednio wykorzystać.

Poziom wirtualizacji serwerów w naszym kraju sięga około 90 proc. Nie oznacza to, że wkrótce nastąpi schyłek rozwoju tej techniki, tym bardziej że wirtualizacja nie ogranicza się przecież do tworzenia w nieskończoność wirtualnych serwerów. Ciekawe perspektywy dla integratorów rysują się w takich segmentach rynku jak chociażby VDI. Wprawdzie od dawna pokładano w tym rozwiązaniu wielkie nadzieje, ale popyt ze strony biznesu cały czas jest daleki od oczekiwań dostawców. Do tej pory wirtualne desktopy najczęściej stosowane były przez wielkie koncerny, które potrafiły docenić niższe koszty zarządzania, a także możliwość lepszego wykorzystania sprzętu komputerowego. Tymczasem boom na zdalną pracę powinien w dalszej perspektywie przyczynić się do wzrostu zapotrzebowania na wirtualne desktopy także wśród mniejszych przedsiębiorstw i urzędów.

Kolejnym rozwojowym obszarem jest wirtualizacja sieci, która otwiera duże możliwości przed integratorami sprzętu. Przedsiębiorstwa w czasie pandemii stanęły przed niełatwymi wyborami, a także przed koniecznością przedefiniowania polityki bezpieczeństwa środowisk wirtualnych. Nie jest to szczególnie trudne zadanie, aczkolwiek zwirtualizowana infrastruktura kryje kilka pułapek.

Największe atuty wirtualnych maszyn, takie jak łatwość tworzenia i migracji, bardzo szybko stały się przekleństwem specjalistów od bezpieczeństwa. Na fizycznym serwerze x86 może być uruchomionych nawet kilkaset maszyn wirtualnych, a wtedy komunikacja między nimi wymyka się spod kontroli. Na szczęście istnieje szeroka gama rozwiązań służących do zabezpieczania wirtualnego środowiska.

– Dostawcy przywiązują dużą wagę do zapewnienia bezpieczeństwa na każdym poziomie systemu wirtualizacyj-nego. VMware chroni całe środowisko, począwszy od najmniejszych komponentów, takich jak karta sieciowa, przez serwery po centra danych. Większość tych mechanizmów znajduje się w podstawowych wersjach oprogramowania – zauważa Jakub Niepsuj, Independent Software Veeam & VMware Team Leader w Tech Dacie.

Eksperci od wirtualizacji i bezpieczeństwa przyznają, że największym problemem w walce z hakerami jest nie brak narzędzi, lecz niewiedza użytkowników oraz niezrozumienie działania mechanizmów. To akurat dobra informacja dla integratorów, którzy sprawnie poruszają się w tym segmencie rynku.

Wirtualne desktopy pod specjalną ochroną

Wraz z wybuchem pandemii setki tysięcy firm z dnia na dzień oddelegowały swoich pracowników do pracy zdalnej. Sytuacja uniemożliwiła wdrożenie zaawansowanych narzędzi, więc przedsiębiorstwa uruchomiły prowizoryczne rozwiązania. Jednak z biegiem czasu przynajmniej część z nich rozszerzy swoją infrastrukturę o elementy, które zwiększają możliwości zdalnego korzystania z plików, aplikacji i danych. Szczególnie skuteczne są w tym zakresie rozwiązania VDI. Niestety, wirtualne desktopy są tak samo podatne na działania hakerów jak komputery fizyczne. Co gorsza, wymagają zastosowania dodatkowych zabezpieczeń. To zazwyczaj niemiła niespodzianka dla firm przenoszących dane z infrastruktury lokalnej do środowiska wirtualnego, bowiem zazwyczaj są przekonane, że mogą wykorzystywać istniejące systemy ochronne.

– Antywirusy chroniące tradycyjne komputery zazwyczaj nie sprawdzają się w przypadku VDI. Po pierwsze, nie widzą warstwy wirtualizacyjnej, a tym samym obciążają procesory maszyn wirtualnych, traktując je jak fizyczne komputery. Po drugie, skanują wszystko, łącznie z systemem operacyjnym. Tymczasem w środowisku wirtualnym to zbędne, ponieważ system operacyjny jest dostarczany z centralnego obrazu w trybie odczytu – wyjaśnia Sebastian Kisiel, Senior Sales Engineer w Citrix Systems.

Spór o agenta

O ile eksperci od wirtualizacji zgadzają się co do tego, że wykorzystanie klasycznego oprogramowania dla potrzeb wirtualnych desktopów to zły pomysł, o tyle w innych kwestiach nie są już tak jednomyślni. Niemałe kontrowersje budzi sposób działania platformy antywirusowej VDI. Niektórzy optują za uruchamianiem agenta na każdej maszynie wirtualnej, inni namawiają, aby wdrażać rozwiązania bez agenta. Mariusz Politowicz, kierownik Działu Technicznego w Markenie, namawia klientów do pierwszej opcji.

– Ochrona bez agenta mniej obciąża komputer i może się sprawdzić tam, gdzie istnieje niewielkie ryzyko ingerencji użytkownika w system. Natomiast w wirtualnych stacjach roboczych należy zastosować ochronę agentową z maksymalnie dużą liczbą modułów – zaleca Mariusz Politowicz.

Dostawcy antywirusów oferują produkty do zastosowania w obu wariantach ochrony środowisk wirtualnych. Na uwagę zasługują także programy z tzw. lekkim agentem. W tego typu systemach skanowanie nie odbywa się na każdej maszynie wirtualnej z osobna, lecz wykonywane jest centralnie przez odrębną maszynę. Informacje dotyczące zagrożeń wymieniane są wyłącznie między serwerami zarządzającym i zdalnego skanowania.

– Lekki agent nie wykonuje tak szerokiego spektrum zadań jak agent w tradycyjnych rozwiązaniach. Kluczową kwestią jest sposób, w jaki skanujemy pamięć. Czy wykorzystujemy opracowane do tego celu narzędzia, czy posługujemy się metodami stosowanymi w klasycznych komputerach PC – mówi Sebastian Kisiel.

Niektórzy integratorzy opowiadają się za rozwiązaniem bez agentów, polecając je firmom o wysokim stopniu konsolidacji zasobów informatycznych, czyli takim, w których na jeden serwer fizyczny przypada duża liczba maszyn wirtualnych.

– W przypadku środowisk mocno ustandaryzowanych i o dużym poziomie automatyzacji występuje efekt skali. Każda dodatkowa czynność wymagająca zautomatyzowania i każdy dodatkowy proces na maszynie wirtualnej może mieć duże znaczenie dla działania całości. Doskonały przykład stanowią środowiska typu VDI, dla których systemy bezagentowe są najczęściej rekomendowanym rozwiązaniem antywirusowym – przekonuje Krzysztof Wyszyński, architekt IT w Netology.

Niezależnie od sposobu ochrony infrastruktury wirtualnej oprogramowanie antywirusowe powinno chronić wszystkie środowiska obsługiwane przez firmę. Należy wziąć pod uwagę platformę serwerową i hiperwizory działające na serwerach VDI, bez względu na to, czy jest to VMware vSphere, Microsoft Hyper-V czy jeszcze inna platforma wirtualizacyjna. Trzeba również sprawdzić, czy antywirus współpracuje z gościnnymi systemami operacyjnymi działającymi na wszystkich maszynach wirtualnych. Jest to ważne, bo czasami firmy używają na niektórych maszynach wirtualnych systemu Windows 7, aby obsłużyć starsze aplikacje.

Zmiany w sieci

W środowiskach zwirtualizowanych procesy zachodzą błyskawicznie. Czas uruchomienia i przenoszenia maszyn wirtualnych liczy się w minutach i sekundach. W tradycyjnych sieciach konfiguracja zajmuje czasami kilka dni. Niewykluczone, że niebawem będzie wymagać mniej czasu dzięki wirtualizacji sieci. To stosunkowo nowy trend, a punktem zwrotnym w jego rozwoju było przejęcie przez VMware w 2012 r. startupu Nicira. W ten sposób koncern z Palo Alto wszedł na rynek sieciowy wcześniej zdominowany przez Cisco. Na odpowiedź nie trzeba było długo czekać. Rok później producent z San Jose przedstawił Application Centric Infrastructure – architekturę wpasowującą się we wszystkie obszary związane z SDN. Wygląda na to, że w segmencie wirtualizacji sieci właśnie Cisco i VMware będą rozdawać karty.

– Czas zastąpić rozwiązania sprzętowe. Z badań przeprowadzonych wśród użytkowników produktów VMware’a wynika, że zastosowanie NSX umożliwia zredukowanie kosztów CAPEX o 59 proc. i OPEX o 55 proc. Nie można przejść obojętnie wobec tych liczb. To jedyny sposób, żeby budować infrastrukturę przygotowaną do obsługi środowiska multicloud – twierdzi Pat Gelsinger, prezes VMware’a.

Rozwiązania sprzętowe nie znikną z dnia na dzień. Niemniej jednak wraz z rozwojem SDN będą się pojawiać nowe koncepcje ochrony sieci. Wiele firm instaluje na brzegach sieci firewalle, wewnątrz systemów operacyjnych rozwiązania do wykrywania i zapobiegania włamaniom, ewentualnie sandboxy. Takie podejście nie gwarantuje pełnego bezpieczeństwa w środowiskach wirtualnych. VMware i Cisco zachęcają do wprowadzenia mikrosegmentacji, choć ich koncepcje nie są tożsame. Rozwiązanie VMware NSX działa bezpośrednio na hyperwizorze i zapewnia izolację wszystkich maszyn wirtualnych, nawet jeśli pracują na jednym serwerze. Może być zastosowane w każdej architekturze sieciowej, nie wymaga zmian topologii ani readresacji aplikacji i uzupełnia narzędzia ochronne używane przez klientów. Nie obejmuje jednak fizycznych przełączników. Z kolei rozwiązanie ACI stworzone przez Cisco umożliwia mikrosegmentację w warstwie przełączników fizycznych, ale nie zarządza wirtualnymi switchami.

– Z punktu widzenia biznesu otrzymujemy podobną korzyść Ważny jest natomiast sposób integracji. ACI jest lepszym rozwiązaniem w sytuacji, kiedy całość zarządzania siecią musi pozostać w jurysdykcji firmowych administratorów. Ale można wybrać wariant, w którym wpływ na kształt usług sieciowych ma osoba odpowiedzialna za wirtualizację. Jeśli firmie nie zależy na zachowaniu maksymalnej spójności rozwiązań sieciowych, może zastosować NSX, który jest tańszy i łatwiejszy w implementacji – twierdzi Krzysztof Wyszyński.

Zdaniem integratora

Krzysztof Wyszyński, architekt IT, Netology

W ostatnich latach firmy przeznaczyły duże środki na nowoczesną infrastrukturę IT. Większość naszych klientów używa zaawansowanych rozwiązań do ochrony danych, również w środowiskach wirtualnych. Często są to topowe produkty z kwadrantu Gartnera. Ale tylko duże przedsiębiorstwa potrafią w pełni wykorzystać ich potencjał. W średnich i mniejszych firmach, choć systemy wdrożono zgodnie z projektem, istnieje problem poprawnego zdefiniowania wymagań. Niejednokrotnie MŚP mają duży problem z określeniem parametrów SLA dla środowisk wirtualnych. Brak odpowiedniej wiedzy uniemożliwia np. należytą ochronę systemów krytycznych.

Zdaniem specjalisty

Przemysław Biel, Key Account Manager Poland, Synology

Docierają do nas sygnały o potrzebie integracji aplikacji antywirusowej z oprogramowaniem do backupu. Nie jest to optymalne rozwiązanie, chociażby dlatego, że dubluje pewne funkcje. W nowoczesnych systemach pamięci masowej antywirusy pozwalają na zabezpieczenie przed wieloma zagrożeniami. Ochrona przed atakami malware wymaga zainwestowania w edukację użytkowników. Systemy kopii zapasowych oraz kopie migawkowe zapewniają szybkie przywrócenie pracy środowiska IT. Najsłabszym ogniwem w zabezpieczeniach przed malware’em i ransomware’em pozostaje człowiek.

Jerzy Skiba, Senior Technical Consultant w Dziale Pamięci Masowych i Serwerów, Veracomp

Jerzy Skiba, Senior Technical Consultant w Dziale Pamięci Masowych i Serwerów, Veracomp

Niemal każda firma i instytucja ma systemy backupu danych, które zabezpieczają zarówno maszyny fizyczne, jak i środowiska wirtualne. Niestety, nadzór nad ich pracą często nie należy do priorytetów działu IT. Zainteresowanie rozwiązaniami pojawia się dopiero, kiedy trzeba odtworzyć dane, czyli stanowczo za późno. Brak odpowiedniego zaangażowania na wcześniejszym etapie powoduje, że odtwarzanie danych przysparza wielu problemów i nie przebiega tak szybko, jak tego oczekują użytkownicy.

Łukasz Milic, Business Development Representative, QNAP

Łukasz Milic, Business Development Representative, QNAP

Głównym wyzwaniem związanym z backupem maszyn wirtualnych jest zapewnienie spójnej kopii bezpieczeństwa systemu i danych oraz możliwość ich szybkiego przywrócenia do działania. Nie mniej ważne jest bezpieczeństwo samych kopii zapasowych. Z tego wynika cała reszta wyzwań. Oczywiście, wielkość zabezpieczanych danych ma istotne znaczenie, ale istnieje proste rozwiązanie – wdrożenie sieci 10 GbE, która zapewnia transfer kopii backupowych nawet o bardzo dużej pojemności.

Backup maszyn wirtualnych

Wiedza przedsiębiorców o ochronie wirtualnych desktopów, a tym bardziej zwirtualizowanych sieci, pozostawia zazwyczaj wiele do życzenia. Zdecydowanie lepiej przedstawia się poziom wiedzy o backupie maszyn wirtualnych. Tomasz Krajewski, Technical Sales Director Eastern EMEA w Veeam, zauważa, że – podobnie jak w przypadku systemów cyberbezpieczeństwa – korzystanie z klasycznych rozwiązań z agentem znacznie obniża wydajność środowisk wirtualnych. Tymczasem specjalistyczne oprogramowanie umożliwia odtworzenie pojedynczego pliku, co obniża koszty tego typu operacji. Warto przy tym zwrócić uwagę na błąd, jaki popełnia wiele firm, polegający na stosowaniu niekompatybilnych zabezpieczeń i budowaniu systemu ochrony wyłącznie z rozwiązań sprzętowych. Z kolei Jerzy Skiba, Senior Technical Consultant w Dziale Pamięci Masowych i Serwerów w Veracompie, wskazuje częste niedopatrzenie wynikające z niedoszacowania potrzeb, zarówno pod względem mocy obliczeniowej, jak i przestrzeni repozytoriów backupu. W efekcie nawet systemy wysokiej klasy nie spełniają wymagań użytkowników.

Niejednokrotnie zdarza się także, że integratorzy bądź użytkownicy narzekają na mankamenty produktów. Gros przedsiębiorców decyduje się na wirtualizację bazującą na platformach VMware vSphere lub Microsoft Hyper-V, a czasami na obu jednocześnie. Wymienione rozwiązania są wspierane przez wszystkie liczące się systemy backupu, w związku z tym ich właściciele nie mają prawa narzekać na brak dostępnych rozwiązań. Jednak firmy, które z oszczędności wdrożyły systemy darmowe (bądź dużo tańsze od dwóch najpopularniejszych wirtualizatorów), mają mocno zawężony wybór oprogramowania do backupu. Dla przykładu: narzędzia Veeam, jednego z liderów tego segmentu rynku, współpracują jedynie ze środowiskami VMware vSphere, Microsoft Hyper-V i Nutanix AHV. Z drugiej strony aplikacja polskiej firmy Storware obsługuje aż siedem platform open source: Nutanix Acropolis/AHV, Red Hat Virtualization/oVirt, KVM, Kubernetes/OpenShift, Citrix XenServer, Oracle VM i Proxmox. Uniwersalność oprogramowania do backupu maszyn wirtualnych stanowi pewnego rodzaju atut, ale wymagania wobec tych produktów najczęściej dotyczą redukcji ilości składowanych danych i szybkiego przywracania systemów do działania. Na pierwszy rzut oka wydaje się, że aplikacje bardzo dobrze radzą sobie z oboma zadaniami, lecz bardziej wnikliwi obserwatorzy dostrzegają ich mankamenty.

– Przywrócenie do działania maszyny o wielkości 1 GB lub 1 TB zajmuje kilka minut. Problem pojawia się, kiedy po ataku ransomware trzeba odtworzyć wiele systemów jednocześnie. Wbrew pozorom nie ma rynku zbyt wielu produktów, które mają efektywne mechanizmy redukcji danych i zapewniają szybkie uruchomienie wielu maszyn wirtualnych z wymaganą wysoką wydajnością. W tym zakresie sprawdzają się jedynie zintegrowane rozwiązania sprzętowe – tłumaczy Krzysztof Wyszyński.

Ataki ransomware spędzają sen z powiek dostawcom systemów bezpieczeństwa i ochrony danych. Niektórzy zachęcają do jeszcze większej integracji tego typu narzędzi z antywirusami. Czasami jednak wystarczą prostsze i od dawna istniejące środki. Dobrym przykładem jest odsyłany od lat do lamusa nośnik fizyczny. Backup na taśmie przechowywanej off-line może bowiem stanowić ostatnią linię obrony przed ransomware’em.

Zdaniem specjalisty

Sebastian Kisiel, Senior Sales Engineer, Citrix Systems

Sebastian Kisiel, Senior Sales Engineer, Citrix Systems

Cyberataki na maszyny wirtualne niewiele różnią się od tych, z którymi na co dzień borykają się użytkownicy fizycznych komputerów. Najczęściej są to phishing i ransomware. Dla hakera środowisko wirtualne nie jest niczym specjalnym, bowiem wychodzi on z założenia, że nadal ma do czynienia z miejscem przeznaczonym do pracy. Forma i sposób zarządzania obrazami maszyn pozwala nieco zminimalizować skutki ataków, jako że wszystkie maszyny VDI są czyszczone automatycznie po wylogowaniu użytkownika i przywracane do stanu sprzed rozpoczęcia pracy.

Tomasz Krajewski, Technical Sales Director – Eastern EMEA, Veeam

Tomasz Krajewski, Technical Sales Director – Eastern EMEA, Veeam

Tworzenie kopii zapasowych maszyn o dużej pojemności nie stanowi obecnie specjalnego problemu. Mechanizmy wbudowane w środowisko platformy wirtualnej umożliwiają zarówno tworzenie kopii zapasowych, jak i odtwarzanie dużych maszyn. Coraz rzadziej jednak ważna jest tylko kopia zapasowa, bo na znaczeniu zyskuje mechanizm odzyskiwania danych. Niezwykle istotnym parametrem jest natomiast czas przywrócenia infrastruktury do działania, gdyż szybka reakcja ogranicza do minimum straty związane z przestojem firmy. Musimy nie tylko wykonywać kopię całej bazy SQL, ale sprawnie przywrócić jej funkcjonowanie razem z aplikacją.

Manfred Berger, Sr. Mgr. Business Development Platforms EMEAI, Western Digital

Manfred Berger, Sr. Mgr. Business Development Platforms EMEAI, Western Digital

Rozmiary maszyn wirtualnych wciąż rosną, stale zwiększa się również liczba i zróżnicowanie aplikacji kontenerowych. Jednocześnie rozwiązania do backupu, archiwizowania i przywracania danych po awarii cały czas ewoluują. Bazują na coraz nowocześniejszych, pojemniejszych i bardziej atrakcyjnych kosztowo dyskach i zapewniają znacznie szerszy zestaw funkcji niż tradycyjne rozwiązania backupu działające na poziomie plików. Wyzwaniem dla użytkowników i dostawców tych rozwiązań jest z pewnością takie zaplanowanie częstotliwości backupu i liczby kopii zapasowych, by możliwe było przywrócenie systemu do stanu sprzed cyberataku czy awarii. Inną ważną kwestią jest oddzielenie backupu od środowiska operacyjnego, dzięki czemu nie staną się jednocześnie celem ataku.

Podobne artykuły

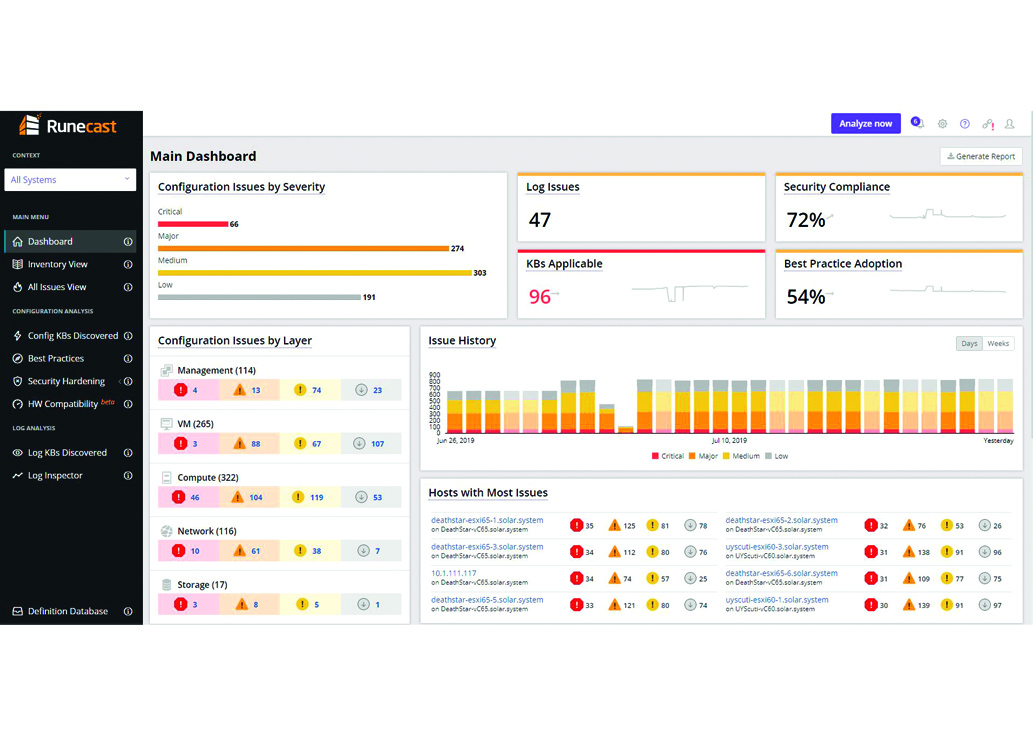

Wirtualizacja pod pełną kontrolą

Oprogramowanie Runecast Analyzer to narzędzie do analizy poprawności i stabilności pracy środowisk wirtualizacyjnych oraz planowania ich rozbudowy. Ułatwia wyeliminowanie ryzyka przestoju i gwarantuje zgodność z normami bezpieczeństwa, przepisami prawa oraz wewnętrznymi regulacjami firm.

Wirtualne maszyny na celowniku hakerów

Konsolidacja zasobów w ramach wirtualizacji niesie ze sobą trudne zadania, a jednym z najważniejszych jest ochrona cyfrowych zasobów. Wymaga ona opracowania odpowiedniej polityki bezpieczeństwa i często wybrania innych rozwiązań niż stosowane w tradycyjnym środowisku.

Serwery i systemy operacyjne, czyli stare po nowemu

Gdy produkty oferowane na rynku coraz mniej różnią się pod względem technicznym, na plan pierwszy wychodzą koszty utrzymania rozwiązań i usługi posprzedażowe.