Koniec kompromisów w pamięciach masowych

W segmencie pamięci masowych dla biznesu ścierają się obecnie różne koncepcje. Co ciekawe, w większości przypadków wskazanie jednoznacznego „faworyta” jest bardzo trudne.

Pandemia koronawirusa nie wpłynęła w zasadniczy sposób na sytuację w segmencie pamięci masowych, chociaż w ostatnich miesiącach nastąpiły pewne tąpnięcia. Jak wynika z danych IDC, w drugim kwartale producenci macierzy dyskowych sprzedali systemy o łącznej pojemności 17,1 eksabajtów, co oznacza wzrost o 5 proc. w ujęciu rocznym. Natomiast w tym samym okresie ich przychody skurczyły się niemal o 8 proc., więc jest to już drugi kwartał z rzędu, gdy wpływy ze sprzedaży macierzy dyskowych lecą w dół. Analitycy tłumaczą taki stan rzeczy przede wszystkim redukcją wydatków przedsiębiorstw na infrastrukturę informatyczną.

Ale nie wszyscy odbiorcy biznesowi ograniczyli zakupy pamięci masowych. COVID-19 nie powstrzymał wzrostu popytu na niebrandowane rozwiązania ODM dla hiperskalowalnych centrów danych, z których zazwyczaj korzystają dostawcy usług chmurowych, bądź tacy giganci jak Facebook czy Apple. W drugim kwartale wartość tego segmentu rynku wyniosła 7 mld dol., a więc o 64 proc. więcej niż w tym samym okresie 2019 r. Jeszcze bardziej imponująco przedstawiają się statystyki dotyczące pojemności tych rozwiązań, której sprzedaż w ujęciu rocznym wzrosła o 122 proc. Wzmożone zakupy, dokonywane w czasie zarazy przez Amazona, Microsofta czy Google’a, były reakcją na zwiększony popyt na usługi chmurowe zarówno ze strony odbiorców biznesowych, jak i użytkowników domowych.

Niezależnie od aktualnej koniunktury, w tle odbywa się wyścig technologiczny, a właściwie jego namiastka. Zdaniem nowych lub stosunkowo nowych graczy rynkowych, do których zalicza się między innymi Gurpreet Singh, CEO startupu Pavilion, architektura macierzy dyskowych od dwóch dekad pozostaje niezmieniona. W tym samym tonie wypowiada się Andres Rodriguez, CTO Nasuni. Jego zdaniem rynek systemów plików od dwudziestu lat praktycznie się nie rozwija, a w kolejnych nowych rozwiązaniach powielane są te same błędy. W rezultacie mamy do czynienia z brakiem elastyczności i generowaniem wysokich kosztów, jak też mało intuicyjną obsługą. Nic dziwnego, że młodzi producenci chętnie krytykują zasiedziałych dostawców w tym segmencie rynku, co stało się zresztą jednym z elementów ich strategii marketingowych.

– W samej architekturze pamięci masowych rzeczywiście nie nastąpił w ostatnich latach żaden poważny przełom. Największym skokiem technologicznym było pojawienie się dysków SSD, ale nie zmieniło to architektury macierzy. Mamy natomiast do czynienia z pewną rewolucją, jaką przyniosło ze sobą zastosowanie sztucznej inteligencji w procesach optymalizacji zarządzania lokalizacją danych. To bezpośrednio przełożyło się na projektowanie i użytkowanie współczesnych systemów – wyjaśnia Piotr Drąg, Storage Category Manager for Poland w HPE.

Prekursorem takiego podejścia jest Nimble Storage, które kilka lat temu wprowadziło do swoich systemów dyskowych mechanizm wykorzystujący sztuczną inteligencję do analizy danych telemetrycznych pochodzących z setek macierzy klientów. Celem jest jak najbardziej skuteczne zapobieganie awariom, a także optymalizacja działania środowiska informatycznego.

Z nieco innej perspektywy na rozwój sytuacji na korporacyjnym rynku pamięci masowych patrzą niektórzy polscy integratorzy. Zwracają chociażby uwagę na zmniejszający się dystans pomiędzy takimi producentami macierzy dyskowych, jak Dell EMC, HPE oraz IBM, a serwerami NAS oferowanymi przez QNAP-a oraz Synology.

– Systemy obu azjatyckich producentów zaczynają zapewniać funkcje oraz wydajność zbliżone do rozwiązań z wyższej półki, a to wszystko za niższą cenę – mówi Jacek Marynowski, prezes Storage IT.

Wojna SAS z NVMe: powolna zmiana warty

Jeszcze do niedawna macierze all-flash były przeznaczone wyłącznie dla najbardziej wymagających użytkowników, w tym instytucji finansowych czy wielkich platform e-commerce. Jednak ostatnie kwartały pokazują, że systemy tej klasy trafiają do coraz szerszego grona odbiorców. Wprawdzie globalny rynek macierzy dyskowych zaliczył w drugim kwartale tego roku spadek, ale sprzedaż rozwiązań all-flash wzrosła niemal o 8 proc., osiągając wartość 2,5 mld dol. Co ciekawe, takie same przychody odnotowano w segmencie systemów hybrydowych. Jeśli ten trend zostanie zachowany, w trzecim kwartale globalne wpływy ze sprzedaży urządzeń all-flash będą wyższe niż w przypadku hybryd.

Warto przy tym zauważyć, że mamy do czynienia z powolną zmianą warty w segmencie najszybszych macierzy. Najważniejsi producenci wprowadzili do swojej oferty systemy z nośnikami NVMe, które podłączone są bezpośrednio do magistrali PCI Express. W ten sposób uzyskali dużo wyższą wydajność niż w przypadku zastosowania nośników SSD ze złączem SAS lub SATA.

Zdaniem integratora

Pandemia nie wpłynęła zasadniczo na zmiany na rynku pamięci masowych. W trakcie lockdownu odnotowaliśmy większe zainteresowanie rozwiązaniami dla klientów z segmentu SOHO/SMB, którzy zgłaszali się po serwery NAS z obsługą VPN. Natomiast większe firmy raczej wstrzymywały inwestycje, czekając na rozwój wydarzeń. Wiele z nich skupiło się na organizacji pracy zdalnej, czyli wyposażeniu pracowników w laptopy z dostępem do zasobów firmowych.

Przykładowo, zoptymalizowany dysk PCIe Gen 4×4 osiąga prędkość transferu od 7,2 do 7,4 GB/s – około 23 razy szybciej niż nośnik SSD z interfejsem SATA i 6 razy szybciej niż SAS 12 Gb/s. Nowy protokół przyspieszy wiele procesów związanych z przetwarzaniem danych, ale nie należy spodziewać się, że w najbliższym czasie wyprze z rynku standard SAS.

– Na chwilę obecną można porównać oba protokoły do świata samochodów, gdzie NVMe to bardzo szybkie auto sportowe, a SAS to dobrej klasy kombi. Nie każdy potrzebuje szybkiego samochodu sportowego. Najczęściej bardziej przydatne w życiu codziennym jest kombi, co oczywiście nie oznacza, że dysponując odpowiednim budżetem nie można posiadać obu – podsumowuje Piotr Drąg.

Pliki czy obiekty

W kontekście przechowywania danych przypadki użycia plików i bloków są doskonale zdefiniowane, ale stosunkowo niedawno pojawiła się trzecia opcja – pamięć obiektowa. Co wyróżnia ją na tle dwóch znanych i powszechnie stosowanych metod? Obiekty są przechowywane w jednym repozytorium, a nie zagnieżdżone jako pliki w różnych folderach lub oddzielnych blokach danych. Architektura eliminuje hierarchiczną strukturę systemu plików i nadaje każdemu obiektowi unikalny identyfikator, dzięki czemu można go bardzo łatwo zlokalizować.

Pamięć obiektowa stanowi interesującą alternatywę dla dużych systemów NAS. Poza tym, że pozwala na łatwiejsze zarządzanie danymi, daje większe możliwości w zakresie skalowalności. Serwery NAS działają bardzo sprawnie w sieci lokalnej (LAN), ale już nieco gorzej w sieciach rozległych (WAN). O ile zarządzanie jednym lub kilkoma urządzeniami jest proste, o tyle w przypadku ich setek może to być prawdziwy koszmar. Wreszcie, popularne NAS-y bez trudu obsługują setki tysięcy plików, ale nie są zaprojektowane do pracy z ich miliardami. Tego typu ograniczenia jeszcze do niedawna nie miałyby żadnego znaczenia, bowiem nikt nie zgłaszał aż tak wygórowanych potrzeb w zakresie przechowywania cyfrowych informacji. Ale wraz z lawinowym przyrostem danych nieustrukturyzowanych sytuacja się zmienia i pojawia się zapotrzebowanie na pamięć obiektową, która bardzo dobrze radzi sobie z najnowszymi wyzwaniami. W początkowej fazie była ona wykorzystywana przede wszystkim do archiwizacji wielkich zbiorów danych, ale to powoli ulega zmianie. Jak wynika z badania przeprowadzonego przez IDC, trzy czwarte ankietowanych szefów IT uważa, że pamięć obiektowa może znaleźć zastosowanie na przykład w projektach związanych z Internetem rzeczy i analizą zasobów nieustrukturyzowanych.

Tego typu opinie nie biorą się znikąd. Przedstawiciele nowej fali nie chcą dłużej tolerować kompromisów pomiędzy wydajnością a pojemnością, które przez długie lata obowiązywały w branży pamięci masowych. Ich działania nie ograniczają się wyłącznie do buńczucznych zapowiedzi, o czym świadczą niedawne premiery systemów Cloudiana czy Scality, oferowanych w wersji all-flash. Z tym, że producenci NAS-ów nie zasypiają gruszek w popiele i rozwijają produkty scale-out, które cechują się nie tylko wysoką skalowalnością, nieporównywalnie większą niż tradycyjne modele scale-up, ale także potrafią zapewnić wysoką wydajność. Tego typu produkty dostarczają Dell EMC, IBM, NetApp czy Qumulo. Ostatnia z wymienionych firm ma wielu klientów z branży multimediów i rozrywki, którzy potrzebują nie tylko bardzo pojemnych dysków, ale również wysokiej wydajności niezbędnej do renderowania plików wideo. Nie bez przyczyny Qumulo ma w swojej ofercie konfiguracje składające się wyłącznie z nośników flash.

Kto wyjdzie zwycięsko z rywalizacji „obiekty kontra pliki”? W małych i średnich firmach pozycja tradycyjnych NAS-ów wydaje się być niezagrożona. Natomiast wśród klientów korporacyjnych dużo trudniej wskazać faworyta. Za pamięcią obiektową przemawia lawinowy wzrost danych nieustrukturyzowanych oraz rosnąca popularność usług chmurowych. Z kolei największym atutem NAS-ów jest siła przyzwyczajenia przedsiębiorców, którzy od lat przechowują dane w plikach i folderach. Trudno więc oczekiwać, że z dnia na dzień zmienią swoje preferencje.

Taśmy od wielu lat pozostają jednym z najważniejszych nośników przeznaczonych od archiwizacji danych. Według analityków IDC, aż 58 proc. cyfrowych zasobów archiwalnych znajduje się na taśmach, z których wciąż korzystają także najwięksi dostawcy usług chmurowych, m.in. Amazon i Microsoft. Duży wkład w rozwój taśm ma zarządzana wspólnie przez HPE, IBM-a i Quantum organizacja Linear Tape Open Consortium, która wprowadza na rynek kolejne generacje nośnika z rodziny LTO Ultrium. We wrześniu pojawiła się generacja LTO-9, która będzie obsługiwać nośniki o pojemności do 18 TB bez kompresji (45 TB z kompresją). Należy dodać, że LTO opublikowało plany dotyczące dalszego rozwoju technologii taśmowej. Przewidują one, że generacja LTO-12 zapewni maksymalną pojemność do 144 TB bez kompresji (360 TB z kompresją). W tym kontekście bardzo ciekawie przedstawiają się zapowiedzi Fujifilm, które zamierza wprowadzić na rynek kasety z taśmą o pojemności 400 TB, a więc 33 razy większej niż w przypadku LTO-8. Japońscy inżynierowie chcą wykorzystać w tym celu właściwości ferrytu strontu (SrFe), podczas gdy obecnie taśmy magnetyczne są pokrywane ferrytem baru (BaFe). Generalnie, w nośnikach każdej generacji LTO wykorzystywane są coraz mniejsze cząsteczki, uformowane w węższe ścieżki danych. Zapewnia to większą pojemność na szpuli taśmy wewnątrz kasety. Jednak, jeśli cząstki BaFe staną się zbyt małe, głowica napędu taśmowego nie będzie już w stanie wiarygodnie odczytać wartości bitów na taśmie. Specjaliści z Fujifilm twierdzą, że SrFe ma lepsze właściwości magnetyczne niż BaFe, co pozwoli osiągnąć wyższy poziom wydajności przy dalszym zmniejszaniu cząstek.

STaaS alternatywą dla chmury publicznej

Dostawcy usług chmurowych przeznaczają coraz więcej środków finansowych na infrastrukturę informatyczną, w tym również pamięci masowe. Według cytowanych wcześniej badań IDC w drugim kwartale br. dostawcy systemów ODM sprzedali 74,8 eksabajtów powierzchni dyskowej – o 57 więcej niż producenci tradycyjnych macierzy. Zarówno Amazon, Google czy Microsoft, jak też mniejsi usługodawcy, nie narzekają na brak klientów w czasie pandemii. Większość firm w niepewnych czasach zamiast inwestować w sprzęt wybiera usługi. Ale koszty związane z przechowywaniem danych u zewnętrznych dostawców wcale nie muszą być niskie. Co gorsza, są one dość trudne do oszacowania. Na pierwszy rzut oka wszystko wydaje się stosunkowo proste. Z cenników wynika, że klient przechowujący w Amazon S3 Standard 50 TB danych płaci 0,023 dol. za GB, zaś w Microsoft Azure Hot Blob Storage cena wynosi 0,184 dol. za GB. Jednak matematyka na tym się nie kończy, bowiem dochodzą opłaty za przesyłanie danych do lub z chmury. Cenniki i regulaminy usługodawców zawierają wiele pułapek, które nie ułatwiają klientom kalkulacji. Przykładowo, Amazon obciąża dodatkowymi kosztami klientów korzystających z publicznego IP.

Alternatywą dla tych, którzy gubią się w chmurowej rachunkowości jest Storage as a Service (STaaS), świadczony w modelu lokalnym. Tego typu usługę oferują najważniejsi gracze na rynku pamięci masowych – Dell Technologies, HPE, Hitachi Vantara, IBM, NetApp, Pure Storage, Quantum i Zadara. Producenci zapewniają szeroką gamę konfiguracji i funkcji, umożliwiając obsługę niemal każdego rodzaju obciążenia. Ten model rozwiązuje wiele problemów i wątpliwości związanych z usługami chmury publicznej, a klienci mogą indywidualnie określić sposób ochrony danych oraz konfiguracji systemów. Lokalny STaaS pozwala między innymi uniknąć opłat za ruch przychodzący i wychodzący. W tej opcji jednak istnieje konieczność zapewnienia miejsca na fizyczny sprzęt wraz z zasilaniem i chłodzeniem. Usługodawca może też wymagać zdalnego dostępu do systemów pamięci masowej w celu ich obsługi, monitorowania i konserwacji.

Trudno przewidzieć jak STaaS przyjmie się w Polsce. Zdaniem Jacka Mary-nowskiego ze Storage IT nie jest to perspektywiczna idea, a ewentualne korzyści nie rekompensują ryzyka działania w takim modelu. Nie brakuje opinii, że to rozpaczliwa próba powstrzymania migracji kolejnych klientów do chmury. Z drugiej strony warto zwrócić uwagę na przykład Zadara Storage – prekursora STaaS. Ta firma z powodzeniem działa na rynku już od dziewięciu lat, a z jej usług korzystają takie koncerny, jak Toyota czy Verizon. A to wystarczająca rekomendacja dla wielu innych klientów, w tym tych najbardziej wymagających.

Zdaniem specjalisty

Aleksander Tarkowski, Solution Architect, Tech Data

Aleksander Tarkowski, Solution Architect, Tech Data Od pewnego czasu mówi się o rzekomym końcu taśm. Nie zgadzam się z tym i uważam, że duża grupa klientów z segmentu enterprise, która jest zainteresowana archiwizacją danych, będzie nadal wykorzystywać taśmy, które mają przecież wiele aktualnych od lat zalet: niski koszt przechowywania per TB, możliwość wyniesienia nośnika poza centrum danych i praktycznie zerowa podatność na zagrożenia typu ransomware. Spadek zainteresowania rozwiązaniami taśmowymi można natomiast zauważyć w przedsiębiorstwach z rynku MŚP. Klienci z tego obszaru do backupu i archiwizacji wybierają rozwiązania bazujące na dyskach.

Wojciech Wolas, Data Center Sales Manager, Dell Technologies

Wojciech Wolas, Data Center Sales Manager, Dell Technologies Do archiwizacji, w ramach której gwarantowana jest niezmienność i niezaprzeczalność archiwizowanych danych, najlepiej nadają się rozwiązania z funkcją nieustannego monitorowania nośników, z wbudowanymi mechanizmami autodiagnostyki czy autokorekcji uszkodzeń nośnika. Wraz z obniżaniem kosztu pojemności, większość systemów archiwizacji będzie wykorzystywała właśnie dyski, a być może później także flash. Gdy archiwizowane są duże zbiory danych, użytkownicy mają do wyboru systemy NAS scale-out bądź pamięć obiektową. Jeżeli zależy im na łatwości i wykorzystaniu popularnych protokołów, lepsze będzie pierwsze z wymienionych rozwiązań. Natomiast jeśli korzystają z aplikacji cloud-native, komunikujących się przez protokoły S3, REST i http, lepsza może okazać się pamięć obiektowa.

Computational storage – inteligentne pamięci masowe Computational storage to architektura umożliwiająca przetwarzanie danych wewnątrz urządzenia pamięci masowej. Jej zastosowanie zmniejsza ilość danych przesyłanych pomiędzy warstwą przechowywania i obliczeniową. W efekcie następuje redukcja wąskich gardeł blokujących operacje wejścia/wyjścia, co z kolei ułatwia analizę informacji w czasie rzeczywistym i poprawia wydajność całego środowiska. W przypadku architektury computational storage wykorzystuje się przynajmniej jeden procesor wielordzeniowy, który służy do wykonywania wielu funkcji, takich jak indeksowanie danych w momencie ich wprowadzania do urządzenia pamięci masowej, wyszukiwanie treści pod kątem określonych wpisów czy obsługa zaawansowanych mechanizmów sztucznej inteligencji. We wrześniu br. specjaliści ARM zaprezentowali układ Cortex-R82 zaprojektowany specjalnie z myślą o tej nowej architekturze pamięci masowych.

Podobne artykuły

Coraz mniej kompromisów

Dostawcy pamięci masowych dla klientów korporacyjnych uporali się z wieloma wyzwaniami, które pojawiły się na ich drodze. To jednak nie koniec „podróży”.

Sprzęt coraz bardziej inteligentny

Producenci sprzętu IT pokładają duże nadzieje w generatywnej sztucznej inteligencji. Bieżący rok przyniesie wstępną weryfikację ich oczekiwań.

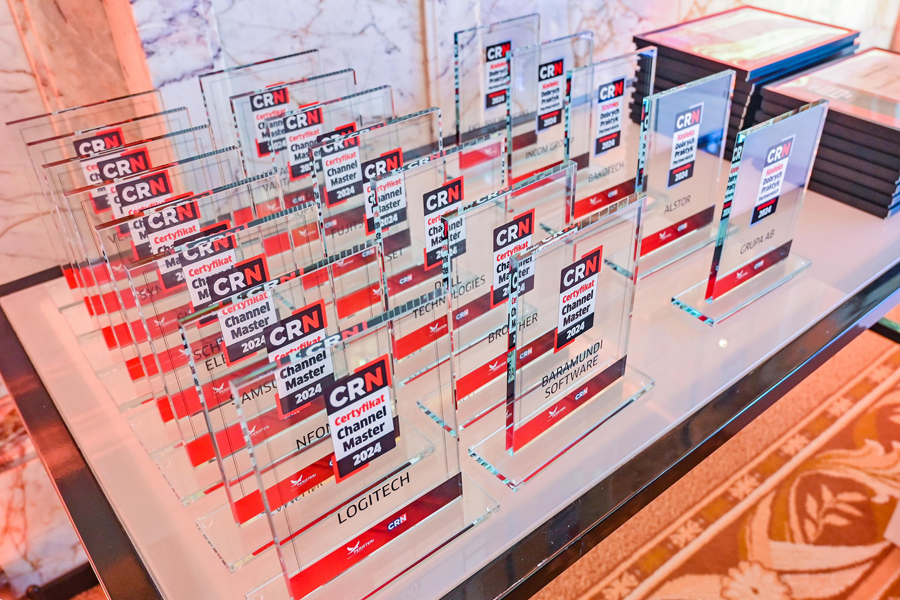

Channel Master 2024: zdobywcy certyfikatów!

Procedurę certyfikacji Channel Master, przeprowadzoną zgodnie z wytycznymi od integratorów IT, w tym roku pozytywnie przeszło piętnastu producentów. Certyfikat stanowi dowód najwyższej dbałości o wysokie standardy i jakość bieżącej obsługi oraz o rozwój ekosystemu partnerskiego.