Gdzie sprzęt się bije tam… oprogramowanie korzysta

Oferowane już od ponad 10 lat macierze all-flash miały bardzo szybko wyprzeć zwykłe dyskowe rozwiązania. Na razie chwilowym zwycięzcą tego pojedynku są systemy hybrydowe, korzystające zarówno z nośników półprzewodnikowych, jak i mechanicznych. Jednak ten model zarządzania danymi, szczególnie w małych i średnich środowiskach, być może odejdzie do lamusa. Wszystko przez coraz tańsze, mniejsze i bardziej pojemne moduły NVMe oraz oprogramowanie do zarządzania przestrzenią dyskową.

Klasycznych macierzy dyskowych, wyposażonych wyłącznie w rotujące napędy, już nie ma na rynku. We wszystkich oferowanych modelach jest możliwość zainstalowania – razem ze zwykłymi dyskami – pamięci SSD w różnej postaci. Mogą to być dyski z tradycyjnym interfejsem SATA/SAS, moduły z interfejsem NVMe czy pamięć na kartach rozszerzeń PCIe. Są wykorzystywane jako zwykłe repozytorium danych na woluminach albo jako pamięć podręczna cache. Jednocześnie coraz większą popularnością cieszą się modele all-flash – te znajdują się w ofercie wszystkich producentów macierzy hybrydowych. Oprócz tego na rynku są dwie firmy – Pure Storage i Kaminario – które nigdy nie produkowały systemów współpracujących z dyskami rotującymi, ale dzięki swojej determinacji uzyskały rynkowy sukces (m.in. są wymieniane jako liderzy rynku pamięci masowych przez Gartnera).

Walka macierzy all-flash z hybrydowymi trwa. Jej nowy front otworzyło dwa lata temu kilku dostawców, którzy „obudowali” swoje rozwiązania dodatkowymi bonusami. Wówczas popularne stały się gwarancje, w ramach których producenci zapewniają uzyskanie przez klienta konkretnego współczynnika kompresji i deduplikacji. Z reguły wynosi on 3:1 lub 5:1 (w przypadku gdy gwarancja nie zostanie dotrzymana, producent zobowiązuje się do dostawy bezpłatnych dysków flash, które zapewnią brakującą pojemność). Jednak każda taka promocja jest obłożona ograniczeniami, np. dane nie mogą być zaszyfrowane lub wcześniej poddane kompresji. Niektórzy producenci gwarantują też teoretycznie bezpłatną wymianę co kilka lat kontrolera macierzy na nowszy model. Teoretycznie, bo gwarancja taka obowiązuje tylko wtedy, gdy klient regularnie korzysta z usług wsparcia, a więc rozliczając się za nie, bierze na siebie koszt wymiany kontrolera.

Według opublikowanych przez IDC w grudniu ub.r. danych wartość sprzedaży macierzy dyskowych na świecie wzrosła tylko o 1,3 proc., a sprzedana pojemność – o 6,8 proc. (ta różnica oczywiście ma związek z taniejącymi nośnikami, głównie półprzewodnikowymi). Długofalowo jest także przewidywana stagnacja, jeśli chodzi o wartość sprzedaży macierzy albo wręcz trend spadkowy. Wszystko z powodu tego, że w coraz mniejszej liczbie firm istnieje konieczność instalowania dużych, zajmujących nieraz całą szafę macierzy dyskowych, by zapewniły oczekiwaną przez działy biznesowe wydajność, np. bazy danych lub środowisk wirtualnych. Do takich zastosowań są wybierane coraz tańsze, ale przede wszystkim pojemniejsze i niepobierające tak dużo prądu pamięci flash (w macierzach all-flash lub jako najszybsza warstwa w systemach hybrydowych).

Co więcej, w celu eliminacji potrzeby budowania fizycznej sieci SAN, bazującej na protokole Fibre Channel, łączącej serwery z dyskami w macierzy, coraz częściej instalowane są nośniki o dużej pojemności bezpośrednio w serwerach. Dzięki temu droga, którą muszą pokonać dane przesyłane między dyskiem i serwerem, jest skrócona do absolutnego minimum.

NVMe wprowadza nowe reguły

Dużo zamieszania w 2019 r. wprowadziło pojawienie się nośników z interfejsem NVMe w macierzach dyskowych, który umożliwia połączenie kości pamięci bezpośrednio z magistralą PCIe. Co prawda prace nad nim rozpoczęto ponad 10 lat temu, by wyeliminować wprowadzające w dyskach SSD wąskie gardła interfejsy SATA i SAS, ale dopiero teraz zyskał należne mu zainteresowanie, głównie dzięki nasilonym akcjom marketingowym producentów.

Protokół NVMe rozwiązuje problem powodowany przez jedno z podstawowych ograniczeń twardych dysków – w danym momencie mogą przetwarzać tylko jedno żądanie (głowica dysku nie może znajdować się w dwóch miejscach w tym samym czasie), a więc transfer danych ma charakter sekwencyjny. Dlatego też interfejsy stosowane w dyskach w ogóle nie przewidywały możliwości równoległego przesyłania większej ilości danych, z czym nie ma problemu w przypadku pamięci flash – tam w jednym cyklu teoretycznie możliwe jest przetwarzanie nawet 64 tys. żądań odczytu.

Równolegle NVMe eliminuje kolejne wąskie gardło, jakim jest infrastruktura sieciowa. Chwilę po stworzeniu protokołu opisującego, jak są przesyłane dane wewnątrz urządzenia, rozpoczęto pracę nad protokołem sieciowym NVMe-oF (NVM Express over Fabrics), który jest w pełni zgodny z NVMe i gwarantuje brak ograniczeń wydajnościowych przy transmisji danych przez sieć. Obecnie sterowniki większości nowych kart sieciowych są już zgodne z nowym protokołem, więc wdrożenie go w serwerach nie powinno stanowić problemu. Niestety, nie są jeszcze gotowi wszyscy producenci macierzy dyskowych, także tych, w których są już wykorzystywane nośniki NVMe, ale rozszerzenie ich funkcjonalności to tylko kwestia czasu i nie będzie wymagało instalacji dodatkowego sprzętu (wystarczy aktualizacja oprogramowania).

Obecnie dyski NVMe bardzo dobrze są przyjmowane jako moduły pamięci masowej w rozwiązaniach infrastruktury hiperkonwergentnej oraz nośniki w zainstalowanych tam serwerach. Decyzja o ich wdrożeniu powinna być jednak podejmowana także na bazie przeprowadzonego u klienta projektu proof-of-concept. Nie zawsze bowiem na współpracę z tak szybkim nośnikiem danych gotowe są aplikacje. Zaobserwowano już przykłady, gdy nie były one w stanie przetworzyć tak dużej ilości informacji, bowiem projektanci oprogramowania założyli, że dane będą spływać relatywnie powoli, z maksymalną prędkością dostępnych w trakcie jego tworzenia twardych dysków.

Projekt proof-of-concept powinien być też przeprowadzony pod kątem sprawdzenia efektywności technik zmniejszających objętość przechowywanych danych – kompresji i deduplikacji. Kompresja sprawdza się dobrze w przypadku każdego rodzaju danych, które nie są zaszyfrowane lub skompresowane z natury (jak pliki multimedialne lub zdjęcia), a szczególnie w bazach danych. Deduplikacja zaś doskonale działa w środowiskach wirtualnych (głównie wirtualizacji desktopów). Problem jednak w tym, że zarówno deduplikacja, jak i kompresja wpływają negatywnie na wydajność, a więc „zabijają” główną korzyść, dla której firmy inwestują w nośniki flash.

Oprogramowanie zarządzi pamięcią masową

Klienci, którzy zastanawiają się nad doborem odpowiednich macierzy dyskowych do zbudowania środowiska pamięci masowych, powinni przyjrzeć się rozwiązaniom alternatywnym, w których główną rolę odgrywa nie sprzęt, ale zarządzające nim oprogramowanie. Co prawda, rozwiązania oferowane pod hasłem Software Defined Storage (SDS) zapewniają różną funkcjonalność, ale obecność na rynku ponad 30 różnych tego typu narzędzi powoduje, że praktycznie każda firma może znaleźć coś, co zaspokoi jej potrzeby w takich obszarach, jak: wirtualizacja serwerów i desktopów, tworzenie chmur hybrydowych, automatyzacja procesów zarządzania infrastrukturą IT czy obsługa elastycznych środowisk DevOps.

Początkowo rozwiązania klasy SDS zapewniały przede wszystkim wirtualizację zasobów pamięci masowych i miały stanowić konkurencję dla bardzo drogich wirtualizatorów sprzętowych, oferowanych przez długi czas wyłącznie przez IBM-a. Ich zadanie polegało na skonsolidowaniu dostępnej w firmowej infrastrukturze IT przestrzeni dyskowej (macierzy z nośnikami o różnej wydajności, napędów w serwerach, kart rozszerzeń z pamięcią flash itp.), zwirtualizowaniu jej, podziale na różne klasy wydajności i udostępnieniu serwerom w wirtualnej sieci SAN w postaci jednego zasobu z gwarantowanym czasem dostępu i transferu danych. Narzędzia te cieszyły się umiarkowanym zainteresowaniem, a przeszkodą wzrostu ich popularności okazała się szybko rosnący popyt na pamięci flash. Dziś funkcja wirtualizacji nadal jest obecna w oprogramowaniu SDS (jej zastosowanie jest konieczne do zapewnienia innych korzyści), ale nie dominująca.

– W obecnych czasach klienci nie są zainteresowani konsolidacją posiadanych starszych zasobów dyskowych. Z reguły nie są one już objęte wsparciem technicznym, są wyposażone w relatywnie wolne dyski o małej pojemności, a przez to pobierają dużo prądu – mówi Jerzy Adamiak, konsultant ds. pamięci masowych w Alstor SDS.

Klasyczne wirtualizatory macierzy dyskowych oczywiście nadal są dostępne. Są w nie wyposażone niektóre modele macierzy dyskowych IBM, Hitachi Vantara, HPE i Huawei. Nadal też można do tego celu wykorzystywać wspomniane wcześniej oprogramowanie klasy SDS (instalowane bezpośrednio jako aplikacja w serwerowym systemie operacyjnym, w wirtualnej maszynie lub uruchamiane w oferowanym przez producentów specjalnym urządzeniu). Jednak głównym celem jego pracy nie jest już wirtualizacja sama w sobie.

Główna zaleta: wysoka dostępność

Użytkownicy narzędzi typu SDS doceniają przede wszystkim możliwość relatywnie taniego tworzenia klastrów wysokiej dostępności, dzięki którym w przypadku awarii jednego z węzłów drugi nadal pracuje i zapewnia pracownikom dostęp do danych. Rozwiązania te świetnie też sprawdzają się podczas różnego typu prac serwisowych – nie ma konieczności wstrzymywania usług przy aktualizacji oprogramowania macierzy, wymianie kontrolerów, a także podczas dodawania do infrastruktury nowych urządzeń. Łatwiejsza jest migracja danych ze starych na nowe macierze (odbywa się w tle, bez wpływu na dostępność środowiska dla użytkowników), a firmy bez problemu mogą decydować się na zakup sprzętu od innego dostawcy niż ten, z którego systemów korzystali wcześniej.

Jedyną trudnością, którą mogą napotkać przyszli użytkownicy rozwiązań SDS (i ich sprzedawcy), jest stosowany przez ich producentów w komunikacji marketingowej nieprecyzyjny język, rzadko opisujący, co dane rozwiązanie robi w rzeczywistości, ale skupiający się na korzyściach (elastyczności, obniżeniu kosztów, integracji ze środowiskiem chmurowym itd.). Dla kogoś, kto w tej dziedzinie nie jest ekspertem, może to stanowić duże utrudnienie, np. w porównaniu do konkurencyjnych produktów. Tu zatem pojawia się niełatwe i odpowiedzialne zadanie dla

integratorów.

Trudności mogą przysporzyć też kwestie związane z finansowaniem. Ze względu na różnorodność funkcji producenci nie wypracowali jednego uniwersalnego standardu wyceny oferowanego oprogramowania. Opłatę można uiszczać jednorazowo, wykupując licencję, a także dokonywać jej w postaci subskrypcyjnej albo płacić za zwirtualizowaną pojemność lub czas korzystania z danego rozwiązania.

Zdaniem specjalisty

Jerzy Adamiak

konsultant ds. pamięci masowych, Alstor SDS

Sytuacja na rynku pamięci masowych bardzo się zmienia dzięki rosnącej popularności dysków NVMe. Oczywiście wciąż są relatywnie drogie, ale jeśli ktoś potrzebuje bardzo szybkiej przestrzeni o dużej pojemności, to raczej będzie go stać na taką inwestycję. Zapewniają niezwykle krótki czas dostępu do danych i ich transfer sięgający gigabajtów na sekundę (kilkunastokrotnie szybszy niż dyski SSD sprzed kilku lat), są też bardzo małe, pojemne i nie pobierają wiele prądu. Dlatego bez problemu w jednym serwerze można zainstalować nośniki zapewniające kilkadziesiąt, a nawet kilkaset terabajtów przestrzeni. Odpada więc konieczność wdrażania skomplikowanych w obsłudze macierzy dyskowych, podłączanych do sieci SAN, niełatwej w konfiguracji i wymagającej ciągłego nadzoru. Jedyne, co jest zalecane, to stworzenie klastra, w którym dane zebrane w serwerze będą replikowane ze względów bezpieczeństwa.

Wojciech Wróbel

Presales Manager, Fujitsu

Macierze all-flash sprawdzają się w coraz większej liczbie zastosowań ze względu na wydajność, o kilka rzędów wielkości większą od tradycyjnych rozwiązań dyskowych. Jednak wciąż w kilku obszarach większy sens ma zastosowanie urządzeń hybrydowych. Moc systemów wyłącznie z dyskami SSD nie zostanie wykorzystana, jeśli będą stosowane do przechowywania plików i ich backupu, szczególnie w typowym środowisku biurowym. W takim przypadku niewielki wzrost wydajności nie zrekompensuje znacznie wyższej ceny samego urządzenia i znajdujących się w nim nośników. Macierze all-flash zdecydowanie rzadziej stosuje się w rozwiązaniach monitoringu wideo, nie tylko z uwagi na pojemność pojedynczych dysków, gdyż obecnie wynosi ona ponad 30 TB. Innymi istotnymi czynnikami są także koszty składowania takich danych (póki co wyższe niż przy dyskach NL-SAS) oraz to, że ich zapis ma charakter ciągły i jest wykonywany w trybie sekwencyjnym, natomiast odczyt jest sporadyczny.

Podobne artykuły

Channel Manager staje się zaufanym doradcą partnera

Obecnie rolą Channel Managera jest zapewnienie partnerom kompleksowego wsparcia nie tylko w zakresie portfolio produktowego, ale też w prowadzeniu działalności biznesowej. Przy czym kluczowym elementem zarządzania kanałem sprzedaży jest efektywna komunikacja z uczestnikami rynku.

Więcej matematyki, mniej szumu

Wielu przedsiębiorców uodporniło się na slogany marketingowe dostawców usług chmurowych, co pozwala zaistnieć na rynku nowym graczom.

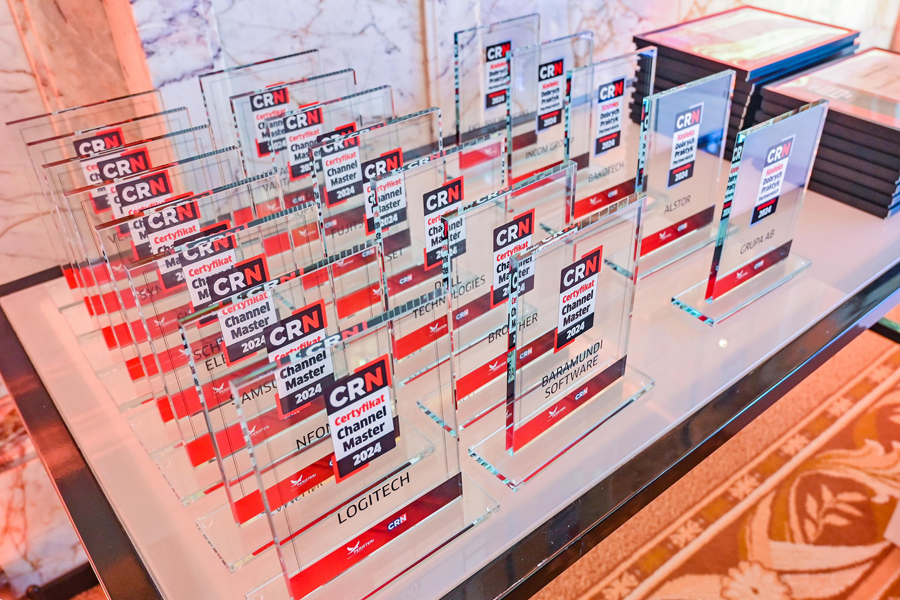

Channel Master 2024: zdobywcy certyfikatów!

Procedurę certyfikacji Channel Master, przeprowadzoną zgodnie z wytycznymi od integratorów IT, w tym roku pozytywnie przeszło piętnastu producentów. Certyfikat stanowi dowód najwyższej dbałości o wysokie standardy i jakość bieżącej obsługi oraz o rozwój ekosystemu partnerskiego.