Fujitsu z nowym partnerem

Fujitsu rozpoczęło współpracę ze startupem Vexata. Rozwiązanie firmy z San Jose pozwoli japońskiemu producentowi dotrzeć do klientów korzystających z najnowszych technologii.

W czasie spotkania prasowego w Sunnyvale, gdzie mieści się Fujitsu Laboratories of America, przedstawiciele obu firmy opowiadali o planach dotyczących współpracy i zaprezentowali macierze all-flash Vexata. Jak na razie jest to rozwiązanie adresowane do wąskiej grupy odbiorców, m.in organizacji wykorzystujących na szerszą skalę sztuczną inteligencji czy mechanizmy uczenia maszynowego. W ostatnich latach coraz głośniej mówi się zbliżającej się milowymi krokami erze kognitywnej, w której pierwszoplanową rolę odgrywać mają samouczące się systemy informatyczne. O ile dość dużo dyskutuje się o wyzwaniach związanych z mocami obliczeniowymi, o tyle kwestie dotyczące przechowywania danych znajdują się na dalszym miejscu. Tymczasem Vexata uważa, że dostępne na rynku pamięci masowe nie są przystosowane do pracy w środowisku kognitywnym.

– Praca z systemami kognitywnymi, obsługa transakcji o wysokiej częstotliwości czy analizy ryzyka i nadużyć finansowych wymagają wyższej wydajności aniżeli oferują tradycyjne macierze all-flash. – tłumaczy Ashish Gupta, CMO Vexata.

Vendorzy nie stoją w miejscu i cały czas poszukują sposobów pozwalających poprawić parametry techniczne urządzeń. Jedną z metod jest instalacja w macierzach nośników NVMe, aczkolwiek Ashish Gupta uważa, iż nie jest to idealna koncepcja.

– NVMe poprawia wewnętrzną wydajność systemu, ale może obciążać kontroler pamięci masowej, który w większości przypadków przetwarza zarówno operacje wejścia / wyjścia, jak i odpowiada za kontrolę ruchu. – tłumaczy Ashish Gupta.

Vexata oddzieliła ścieżki danych oraz sterowania, powierzające realizację operacji I/O akcelatorowi FPGA (Field Programmable Gate Array). Każda jednostka pamięci masowej posiada układ FPGA, producent nazywa go routerem VS-OS, zwiększający przepustowość systemu.

– Macierz VX-100M z nośnikami Optane 3D XPoint osiąga wydajność 7 milionów IOPS, opóźnienie wynosi 40 mikrosekund, zaś przepustowość 80 GB/s. To parametry lepsze aniżeli osiągają tradycyjne macierze all-flash. – dodaje Ashish Gupta.

Vexata może wykorzystywać standardowy procesor X86 do zarządzania wszystkimi funkcjami sterującymi VX-OS, utrzymując odpowiednią wydajność i jednocześnie obniżając koszty. To ciekawa opcja np. dla użytkowników oprogramowania Oracle, gdzie opłata licencyjna zależy od ilości rdzeni na urządzeniu.

– 70 proc. systemów pamięci masowych stanowią koszty nośników. Wszyscy producenci kupują te same dyski, płacąc za nie identyczną cenę. My wyróżniamy się innowacyjną architekturą. – mówi Ashish Gupta.

Fujitsu nie bez przyczyny zaprosiło dziennikarzy do swojego laboratorium w Dolinie Krzemowej. Nowo uruchomiony ośrodek ma być miejscem, gdzie japoński producent zamierza wspólnie ze startupami budować ekosystem technologiczny i biznesowy. Projekty mają być związane z chmurą hybrydową, internetem rzeczy czy sztuczną inteligencją.

– Współpraca z Vexata pozwoli klientom przejść drogę od tradycyjnych rozwiązań informatycznych BI do AI. Wraz z upływem czasu będziemy obserwować migrację z obecnej architektury, w której macierze obsługują cztery warstwy danych na model ograniczony do trzech: kognitywnej, tradycyjnej oraz backupu i archiwizacji – tłumaczy Alex Lam Vice President & Head of the North America Strategy Office w Fujitsu.

W czasie spotkania Fujitsu przedstawiło architekturę referencyjną składającą się z trzech serwerów Primergy RX2540, dwóch przełączników Mellanox SN2700 100GbE i systemu Vexata VX-100FS NVMe-oF.

Podobne artykuły

Channel Manager staje się zaufanym doradcą partnera

Obecnie rolą Channel Managera jest zapewnienie partnerom kompleksowego wsparcia nie tylko w zakresie portfolio produktowego, ale też w prowadzeniu działalności biznesowej. Przy czym kluczowym elementem zarządzania kanałem sprzedaży jest efektywna komunikacja z uczestnikami rynku.

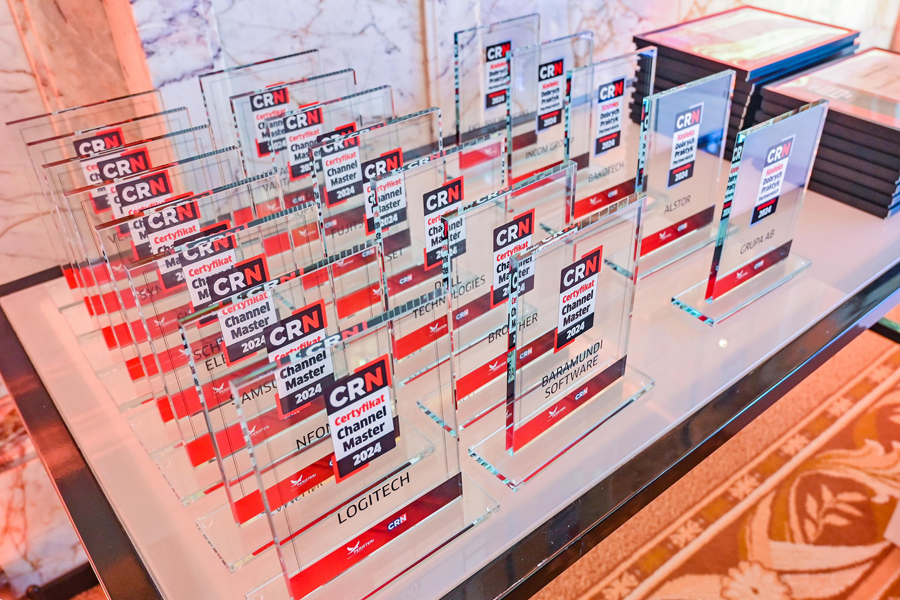

Channel Master 2024: zdobywcy certyfikatów!

Procedurę certyfikacji Channel Master, przeprowadzoną zgodnie z wytycznymi od integratorów IT, w tym roku pozytywnie przeszło piętnastu producentów. Certyfikat stanowi dowód najwyższej dbałości o wysokie standardy i jakość bieżącej obsługi oraz o rozwój ekosystemu partnerskiego.

Chmura i usługi w programach partnerskich

Model usługowy wymusza zmianę benefitów, szkoleń, modelu rozliczeniowego, a nawet statusów partnerskich. Co ważne, w ramach nowego podejścia, producenci oczekują od integratorów większej samodzielności.