Backup coraz tańszy i prostszy

Coraz łatwiej przekonać klientów do wdrożenia systemu tworzenia kopii bezpieczeństwa danych, czyli backupu. Praktycznie każdy, kto – w ten czy inny sposób – stracił jakiś plik, docenił fakt, że można go odzyskać. To znacznie ułatwia dyskusję z klientami i sprowadza ją do ustaleń, jak efektywnie i tanio wdrożyć system bezpieczeństwa, a nie czy w ogóle jest on potrzebny.

Konieczność wykonywania kopii bezpieczeństwa danych jest tak stara jak same systemy IT. Początkowo rozwiązania pamięci masowych były dość zawodne, więc ważne informacje tracono dość często. W tych dzisiejszych poziom „upakowania” danych jest miliony razy większy, więc gdy na jednym twardym dysku można zmieścić wszystkie firmowe zasoby, utrata nośnika – jedynego źródła informacji – może być fatalna w skutkach.

Mimo że mamy dziś do czynienia ze znacznie bardziej niezawodnym sprzętem, nie znika potrzeba backupu. Wręcz przeciwnie – coraz częściej pojawia się on w zapisach prawnych jako proces, którym muszą być objęte dane przetwarzane przez firmę. Zarządy przedsiębiorstw (wreszcie) zaczęły uświadamiać sobie, że najbardziej wartościowym, posiadanym przez firmę zasobem, jest informacja, dlatego brak dostępu do niej może kosztować znacznie więcej, niż skradziony laptop czy nawet cały system do wykonywania kopii bezpieczeństwa.

Wyzwania na dziś i jutro

Tak szybko jak zmienia się rola systemów IT w firmach, rosną też wymagania wobec sposobów przechowywania i zabezpieczania informacji. Przede wszystkim nie sposób nie zauważyć dosłownie eksplozji ilości danych (przyrost rzędu 40–60 proc. rocznie) pojawiających się w firmie. Ma na to wpływ przede wszystkim zwiększenie szczegółowości informacji przetwarzanych przez przedsiębiorstwa – obrazy i wideo są w coraz lepszej rozdzielczości, zbieramy coraz więcej danych o klientach, Internet stał się kopalnią wiedzy, którą chętnie zapisujemy na twardych dyskach, a do tego dochodzi trend big data, który w wybranych firmach powoduje, że zbieramy informacje o wszystkim i wszystkich.

Dodatkowym problemem jest fakt, że jeszcze kilka lat temu tylko 10 proc. danych miało dla firm krytyczne znaczenie, obecnie współczynnik ten jest szacowany na 50 proc. Co gorsza, mamy coraz więcej ważnych danych, a coraz mniej czasu na wykonanie ich kopii. Kurczą się, a czasem całkowicie znikają, tzw. okna backupowe, czyli czas, w którym można (bez uszczerbku dla ciągłości pracy systemów IT) wykonać kopię bezpieczeństwa. Wiele firm skarży się, że nie jest w stanie całkowicie wstrzymać pracy swoich serwerów, aby przeprowadzić backup. Ma to związek głównie z koniecznością udostępniania ich systemów klientom przez Internet w trybie 24/7. Dlatego konieczne jest zbudowanie rozwiązania, które uwzględnia ten bardzo ważny parametr.

Kolejne wyzwanie przyniosły coraz popularniejsze środowiska wirtualnych serwerów i desktopów. Płynące z ich stosowania korzyści są doceniane przez firmy, ale szybki backup i sprawne odzyskanie zasobów przysparza niemałych problemów. Pierwotnie podejmowano próby zabezpieczania danych przez agenta wewnątrz wirtualnej maszyny, ten proces jednak był dość powolny, obniżał wydajność jej pracy i wymagał ciągłego nadzoru administratorów. Skuteczniejsze okazały się próby backupu całych wirtualnych maszyn z poziomu hypervisora. W tej sytuacji backup trwał jednak jeszcze dłużej (w rozwiązaniu tego problemu w dużym stopniu pomógł mechanizm deduplikacji), a odtworzenie pojedynczej wirtualnej maszyny pochłaniało nawet kilkanaście godzin. Dlatego firmy produkujące oprogramowanie do backupu skutecznie skupiły się na zapewnieniu możliwości uruchomienia wirtualnej maszyny bezpośrednio z wykonanej kopii (oczywiście z pewnym uszczerbkiem dla jej wydajności) i równoległym jej odtworzeniu w środowisku podstawowym.

Jednym z ważnych postulatów zgłaszanych przez użytkowników była potrzeba tzw. granularnego odzyskiwania (ang. granular recovery) danych, czyli uzyskania dostępu do pojedynczych plików z wykonanej kopii bezpieczeństwa (także z maszyn wirtualnych) lub rekordów z bazy danych. W tej chwili coraz więcej firm tworzących oprogramowanie do backupu już oferuje tę funkcję.

Backup, archiwizacja i kopia zapasowa

Najczęściej mylonymi pojęciami w kontekście przechowywania oraz ochrony danych są backup i archiwizacja.

Backup to tworzenie kopii bezpieczeństwa (nie mylić z kopią zapasową, o której za chwilę). Jest to cały, wcześniej zaprojektowany proces (a nie konkretna czynność), w ramach którego wykonywana jest kopia plików i/lub całych systemów operacyjnych albo baz danych. Kopię tę tworzy się po to, aby w przypadku wystąpienia awarii można było w jak najkrótszym czasie przywrócić dostęp do zabezpieczonych danych. Podczas wykonywania backupu dane nie są kasowane ze swojego oryginalnego miejsca przechowywania.

Tymczasem archiwum to zbiór danych historycznych, wykorzystywanych rzadko lub wcale, ale takich, które wciąż mają dla firmy jakąś wartość. W procesie archiwizacji dane są przenoszone do archiwum (a więc kasowane ze źródła). Najlepiej byłoby jednak, gdyby istniał stały dostęp do nich oraz możliwość ich odtwarzania i przeszukiwania. W systemach wykorzystywanych jako archiwum stosowane są tańsze i wolniejsze nośniki niż w systemach produkcyjnych – obecnie głównie twarde dyski Serial ATA lub taśmy.

Natomiast wspomniane wcześńiej pojęcie kopii zapasowej może obejmować zarówno nośniki z backupem, jak i archiwum. Jest to dodatkowa kopia danych, najczęściej na nośniku wymiennym (chociaż dziś można rozważyć także wykonanie takiej kopii przez Internet, w ramach usługi wykupionej u zewnętrznego dostawcy). Okaże się nieoceniona gdy, wskutek wypadków losowych (pożar, zalanie itp.), zniszczeniu ulegną zarówno systemy produkcyjne firmy, jak i nośniki z kopią bezpieczeństwa oraz archiwum.

Niech zarząd oceni ryzyko…

Wybór sposobu przeprowadzania backupu powinien też być uzależniony od ilości danych, które można utracić, i planowanego czasu odtworzenia danych. Czynniki te określają precyzyjnie dwa parametry – RPO i RTO.

Recovery Point Objective (RPO) określa moment w przeszłości, w którym po raz ostatni została wykonana kopia danych, czyli moment działalności, do którego będzie można wrócić. Jednym wystarczy kopia z wczoraj, inni zaś potrzebują danych sprzed kilkunastu sekund. Na dłuższe czasy RPO (rzędu kilku dni) można sobie pozwolić np. w przypadku serwerów, których konfiguracja zmienia się rzadko (serwery wydruku, DNS, Active Directory). Dla plików i serwerów internetowych wskazana będzie kopia z ostatniej nocy. W przypadku baz danych lub informacji płynących ze sklepów internetowych utrata danych nawet sprzed godziny może skutkować rysą na wizerunku firmy. Dlatego trzeba zadbać o jak najkrótszy czas RPO, a najlepiej replikować dane na drugą macierz w czasie rzeczywistym.

Krzysztof Rachwalski

dyrektor regionalny, Veeam

Dostępne dziś rozwiązania wirtualizacyjne ułatwiają bardzo szybkie tworzenie kolejnych wirtualnych maszyn, ale trudno w nich szukać sposobu na równie prosty i szybki backup. To właśnie ten obszar najbardziej utrudnia życie administratorom odpowiedzialnym za wirtualne środowisko. Przyznają oni, że przy tradycyjnym backupie odzyskanie pojedynczej wirtualnej maszyny może trwać nawet 24 godziny, co jest dziś czasem absolutnie niemożliwym do zaakceptowania. Administratorzy szukają rozwiązania, które umożliwi na przykład uruchomienie wirtualnej maszyny bezpośrednio z wykonanej wcześniej kopii zapasowej.

Drugi ważny parametr – Recovery Time Objective (RTO) – to maksymalny czas po awarii potrzebny do przywrócenia działania aplikacji, systemów i procesów biznesowych. Podobnie jak w przypadku czasu RPO, gdy przywrócenie do pracy musi nastąpić w ciągu sekund lub minut, należy zbudować system ochrony danych z wykorzystaniem rozwiązań klastrowych. Jeśli mamy do dyspozycji kilka godzin, możemy ręcznie odzyskiwać pojedyncze pliki lub maszyny wirtualne. Dopiero gdy możemy pozwolić sobie, by brak dostępu trwał cały dzień, należy rozważać pełne odtworzenie całego systemu z backupu.

Czasy RPO i RTO zawsze będą kompromisem między potencjalnymi stratami a kosztami rozwiązania umożliwiającego jak najszybsze odtworzenie stanu sprzed awarii i jak najmniejszą stratę danych. To element ryzyka biznesowego, którego oceny powinien dokonywać nie tylko dział IT czy świadczący usługi konsultacyjne reseller lub integrator, ale przede wszystkim zarząd firmy. On bowiem finalnie będzie brał odpowiedzialność za straty zarówno finansowe, jak też wizerunkowe.

Z jakich klocków zbudować backup?

Z systemami do backupu przez kilkadziesiąt lat były kojarzone głównie taśmy. Ich najważniejsze zalety pozostały niezmienne do dziś: bardzo duża pojemność oraz szybkość zapisu, a także możliwość wywiezienia nośnika z siedziby firmy. Jednak w systemach backupu taśmy przestały być doceniane, ze względu na podstawową wadę – bardzo długi czas odzyskiwania danych (w skrajnych przypadkach sięgający nawet kilku dni) i częsty brak możliwości dostępu do pojedynczych obiektów zapisanych na taśmie, co przekłada się na konieczność odzyskania całego backupu.

Backup dyskowy, w którym dane są kopiowane na podłączone do infrastruktury IT macierze, wyparł z tych zastosowań rozwiązania taśmowe. Kopię bezpieczeństwa danych ze stacji roboczych najczęściej wykonuje się przez sieć i umieszcza na udostępnionym w tym celu wolumenie serwera NAS. Dane z serwerów kopiuje się w podobny sposób, a jeśli jest ich dużo do przeniesienia, trafiają na klasyczne macierze dyskowe przez protokół iSCSI lub Fibre Channel. Wadą tego rozwiązania jest znacznie wyższy koszt oraz pobór prądu, ale zalety (szczególnie w obliczu konieczności szybkiego odzyskania danych i uniknięcia wizerunkowej katastrofy firmy) znacznie je przewyższają. Dostęp do utraconych danych można uzyskać niemal natychmiast (niektóre programy do backupu umożliwiają pracownikom odzyskiwanie skasowanych plików lub ich wcześniejszych wersji), a dane z macierzy dyskowej w takim środowisku można replikować do pomieszczenia znajdującego się w innym budynku, co zastępuje wywożenie taśm poza siedzibę firmy.

Jerzy Adamiak

konsultant ds. pamięci masowych, Alstor

Dyski są niezastąpione, jeśli chcemy szybko odtworzyć dane z backupu, jednak do stworzenia kopii poza siedzibą firmy z wykorzystaniem technologii dyskowych – co jest jednym z podstawowych wymagań backupu – konieczna jest replikacja, a ta już jest dość droga. Dlatego taśmy jeszcze przez długi czas będą wykorzystywane w rozwiązaniach backupu dysk-dysk-taśma jako wymienny nośnik o bardzo korzystnym współczynniku pojemności do ceny.

Arthur Kilian

Channel Sales Manager CEE, Imation

Sprzedaż systemów RDX w Polsce cały czas rośnie, chociaż nie w takim tempie jak na Zachodzie. Często realizowane są projekty dla instytucji z dużą liczbą oddziałów – sieci sklepów lub jednostek administracji publicznej. Tam backup najczęściej odbywa się centralnie, jednak ze względu na długi czas odzyskania informacji z takiej kopii firmy decydują się na prowadzenie także backupu lokalnego, z wykorzystaniem wymiennego nośnika.

– Sukcesu wielofunkcyjnych, małych macierzy dyskowych można upatrywać w tym, że m.in. świetnie sprawdzają się w procesie backupu – mówi Renata Krajewska, odpowiedzialna za sprzedaż rozwiązań Synology na rynku polskim. – Dzięki nim mniejsze firmy mogą nie tylko korzystać z taniej i dostępnej przestrzeni dyskowej w sieci, ale też chronić dane na dyskach w macierzy RAID, podłączonych zewnętrznych napędach lub w chmurze. Mniej doświadczonym użytkownikom ułatwia pracę przyjazny w obsłudze system operacyjny i możliwość konfigurowania poszczególnych funkcji za pomocą kreatorów.

Same taśmy oczywiście nie znikną, zmienia się tylko ich rola. W wielu systemach backupu (w modelu dysk-dysk-taśma) są wykorzystywane jako dodatkowe zabezpieczenie. Pierwszą kopię przenosi się do zasobu dyskowego (i stamtąd w razie potrzeby można szybko odzyskać dane), a kopia na taśmie jest wykonywana w celu dodatkowego zabezpieczenia lub spełnienia wymagań zawartych w przepisach prawnych.

Coraz częściej taśmy wykorzystywane są też do archiwizacji danych. Zastąpiły w tym obszarze nośniki optyczne i magnetooptyczne, ze względu na nich znacznie mniejszą pojemność. Budując taśmowe archiwum, należy jednak pamiętać, że zadanie informatyka nie kończy się w momencie odłożenia taśmy na półkę. Producenci zwykle dają od 4 do 10 lat gwarancji na taki nośnik, a taśma przechowywana przez dłuższy czas powinna być okresowo przewijana (zwykle co rok), zaś jej zawartość przepisana na inną taśmę co kilka lat. W ten sposób zapewnimy sobie możliwość odczytu danych bez konieczności przechowywania starych napędów taśmowych, zgodnych z obowiązującym w momencie ich produkcji standardem zapisu. Oczywiście cały czas trzeba też pamiętać o „logicznej” migracji danych do nowych formatów plików lub zagwarantowaniu sobie kompatybilności wstecznej w tym zakresie.

Aby backup był łatwiejszy

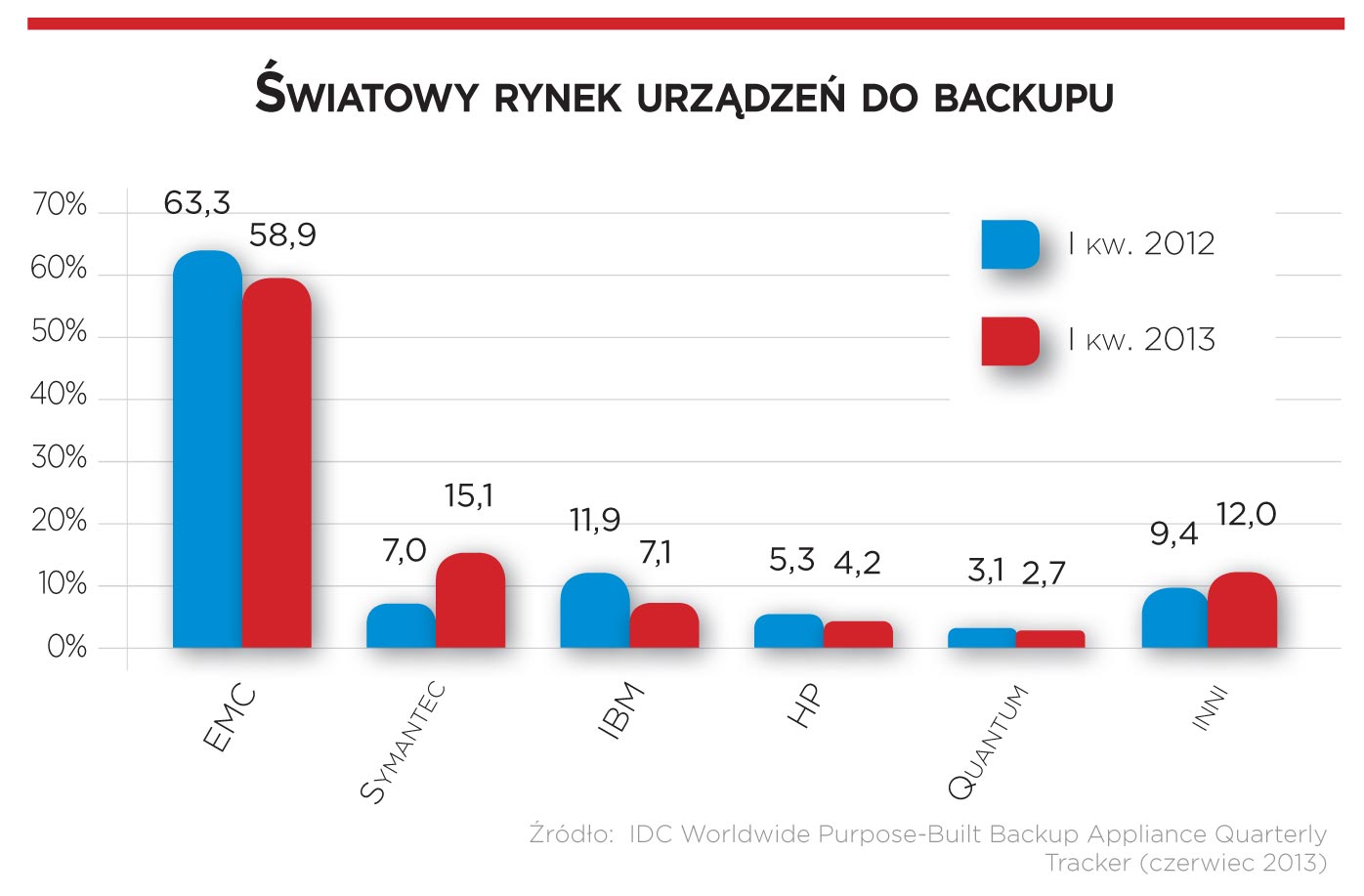

Coraz aktywniej promowanym przez firmy rozwiązaniem w ostatnich miesiącach są urządzenia do backupu (ang. backup appliance). To połączenie macierzy dyskowej z serwerem wyposażonym w oprogramowanie do backupu. W czołówce tego rynku (według IDC) są: EMC, Symantec, IBM, HP i Quantum. Warto tu zwrócić uwagę na Symanteca, który w ostatnim roku odnotował prawie 150-proc. wzrost sprzedaży.

– Pomysł urządzeń do wykonywania backupu jest ciekawy, chociaż raczej ich zastosowanie będzie ograniczone – mówi Jerzy Adamiak, konsultant ds. pamięci masowych w Alstorze. – Nadal trzeba mieć pomysł na strategię wykonywania backupu w firmie i umieć ją zaimplementować, konfigurując takie urządzenie. Nie zyskujemy też oszczędności finansowych, bo cena takiego rozwiązania jest wyższa niż dotychczas stosowanego sprzętu i oprogramowania zapewniających podobną funkcjonalność. Podobnie długo trwa wdrożenie nowego systemu, bo nadal trzeba instalować agentów na wszystkich backupowanych urządzeniach.

Na te zarzuty odpowiada Robert Grzyb, National Key Account Manager Storage w polskim oddziale LenovoEMC, która we wrześniu wprowadziła na rynek podobne urządzenie z pamięcią masową LenovoEMC px oraz oprogramowaniem Acronis.

– Rozwiązaniom typu appliance zarzuca się często dwie wady – małą elastyczność oraz wysoką cenę, często wyższą od kosztu zakupu oddzielnego sprzętu i oprogramowania. Nasza strategia eliminuje te dwa problemy, ponieważ klienci mają dostęp do całej palety dodatkowych licencji, dzięki

którym mogą dostosować rozwiązanie do specyficznych potrzeb – przekonuje rozmówca CRN Polska.

O tym, że rynek urządzeń do backupu będzie rozwijał się coraz szybciej, świadczą zdecydowane ruchy największych graczy związanych z pamięciami masowymi. W 2012 r. WD kupił Arkeia Software, producenta oprogramowania do backupu i macierzy działających jako backup appliance. W czerwcu br. zostały zaprezentowane pierwsze tego typu produkty już pod nową marką. Wszystko wskazuje, że nowych pomysłów na wykonywanie kopii bezpieczeństwa danych można się spodziewać jeszcze więcej.

Idzie nowe

Firmy, widząc jak cennym zasobem są posiadane przez nie informacje, wymusiły na dostawcach sprzętu podjęcie prac nad nowymi sposobami wykonywania backupu. Zaprezentowaną już w 2007 r. ciekawostką były kartridże RDX, które funkcjonalnością przypominają taśmy, ale wewnątrz kasety mają 2,5-calowy twardy dysk o zwiększonej odporności na uszkodzenia fizyczne, np. w wyniku upadku. Czytniki dysków RDX (produkowane obecnie przez Imation i Tandberg Data) można podłączać przez port USB 3.0. Dostawcy deklarują ich poprawną pracę nawet przez 10–15 lat, pod warunkiem używania nie dłużej niż przez 3–4 godziny dziennie.

Obok czytników dostawcy RDX oferują też biblioteki dyskowe – urządzenia sieciowe, mieszczące osiem kartridży, które mogą pracować w trzech trybach: emulacji fizycznej biblioteki taśmowej (osiem kartridży jako trzy napędy LTO), JBOD (osiem dysków z oddzielnymi wolumenami lub jeden duży wolumen) albo iSCSI, gdzie każdy ze slotów można przyporządkować do jednego klienta do backupu przez sieć. Maksymalna pojemność takiego urządzenia wynosi obecnie 12 TB.

Kolejną interesującą koncepcją, która prawdopodobnie w najbliższym czasie bardzo się rozwinie, jest backup w chmurze. Może być on realizowany na dwa sposoby – w ramach usług backupu online (dla stacji roboczych) lub Storage as a Service (głównie dla serwerów). Więcej na temat backupu online piszemy w artykule „Świetne perspektywy backupu przez Internet” na str. 50.

W systemach backupu świetnie sprawdza się – także istniejąca już od paru lat, chociaż wciąż niedoceniana – technika deduplikacji. Umożliwia eliminację powtarzających się obiektów (plików i bloków danych) dokonywaną za pomocą algorytmu wykonywanego w macierzy dyskowej (deduplikacja na urządzeniu docelowym) lub oprogramowania na serwerze lub stacji roboczej (deduplikacja na urządzeniu źródłowym). Rozwiązanie to świetnie sprawdza się szczególnie w środowisku wirtualnych maszyn, gdzie powtarzalność danych, w związku z istnieniem kopii tych samych wersji systemów operacyjnych wewnątrz maszyn, jest wyjątkowo duża.

Wszystko wskazuje na to, że już wkrótce deduplikacja powinna stać się ogólnie przyjętym standardem. – Mniejsze firmy do niedawna nie były nią zainteresowane – twierdzi Ewelina Kurzeja, Product Manager EMC, S4E. – Najczęściej do backupu stosowały taśmy, nie biorąc po uwagę, że repozytorium dyskowe z deduplikacją zapewnia większe bezpieczeństwo i efektywność, dzięki możliwości znacznie szybszego tworzenia kopii i odtwarzania danych z backupu. Obecnie klienci wiedzą na ten temat więcej, a korzyści z deduplikacji, szczególnie w środowisku wirtualnym, dostrzegają już prawie wszyscy.

Wszystko wskazuje, że nowych pomysłów na wykonywanie kopii bezpieczeństwa danych wkrótce można się spodziewać jeszcze więcej.

Główni producenci rozwiązań do backupu oraz ich dystrybutorzy na polskim rynku

Sprzęt

Dell: AB, ABC Data, Connect Distribution

EMC: Arrow ECS, S4E

Fujitsu Technology Solutions: AB, ABC Data, Tech Data, Veracomp

Hitachi Data Systems: Avnet

HP: AB, ABC Data, Tech Data, Veracomp

IBM: Arrow ECS, Avnet, RRC, Tech Data

Główni producenci rozwiązań do backupu oraz ich dystrybutorzy na polskim rynku – cd.

Imation: Action, Alstor,

Diskus, Veracomp

Infortrend: Alstor, Asbis, EPA Systemy, Veracomp

LenovoEMC: AB, S4E, Tech Data, Veracomp

NetApp: Arrow ECS

Netgear: AB, ABC Data,Action, Tech Data, Veracomp

Oracle/Sun: Arrow ECS

Overland Storage: Alstor, Zycko

QNAP: EPA Systemy, Konsorcjum FEN, Veracomp

Quantum: S4E, Veracomp

Promise: Alstor, Asbis, Format

Seagate: AB, ABC Data, Asbis, Avnet, GDS

Distribution, Incom

Sepaton: S4E

Synology: AB, EPA Systemy, Veracomp

Tandberg Data: ABC Data,

Action, Alstor, Veracomp

Thecus: AB, EET, EPA Systemy

WD: ABC Data, Action, Incom, Tech Data

Zenith ARCA: S4E

ZyXEL: AB, Action, eD’System, RRC, Veracomp

Oprogramowanie

Acronis: Clico

Arkeia: Dagma

Asigra: Zycko

Atempo: S4E

CA: Alstor, Veracomp

CommVault: Alstor, Avnet

Dell: AB, ABC Data, Connect Distribution

EMC: Arrow ECS, S4E

EVault: Alstor

FalconStor: Avnet, S4E, Zycko

HP: AB, ABC Data, Tech

Data, Veracomp

IBM: Arrow ECS, Avnet, RRC, Tech Data

Microsoft: AB, ABC Data, Action, Incom, Tech Data

NetApp: Arrow ECS

Symantec: ABC Data,

Arrow ECS, Tech Data

Veeam: Avnet, Veracomp

Podobne artykuły

Dane w trendzie wzrostowym

Wartość danych wzrasta, a wraz z nią koszty związane z ich zabezpieczaniem. Firmy w najbliższych latach będą musiały udźwignąć ten ciężar.

Microsoft 365: Barracuda gwarantem dostępu do danych

Zabezpieczenie wszystkich informacji przechowywanych w usłudze Microsoft 365 oraz gwarancję nieprzerwanego korzystania z nich zapewnia oferowana przez Barracuda Networks usługa Cloud-to-Cloud Backup.

Wielkie pieniądze na wielkie zbiory danych

Choć za oceanem sporo mówi się o nadchodzącej recesji, a giganci technologiczni ograniczają zatrudnienie, wciąż nie brakuje środków finansowych na ciekawe projekty IT.